和歌山旅行のしおり

今日から3日ほど和歌山県に旅行に行ってくるので、旅行のしおりをGitHubで公開しておきますね。

まだ間に合うので、オススメスポットとかの情報あったら気軽にPull Requestくださいね。

それでは行ってきまーす(多分)

今日から3日ほど和歌山県に旅行に行ってくるので、旅行のしおりをGitHubで公開しておきますね。

まだ間に合うので、オススメスポットとかの情報あったら気軽にPull Requestくださいね。

それでは行ってきまーす(多分)

私の会社には「ディープラーニングおじさん」がいます。「います」といっても私が勝手に一人で心の中でそう呼んでいるだけですが…ともかく、今日はその「ディープラーニングおじさん」が、機械学習経験ゼロから、最終的に会社を動かすまでの華麗なる軌跡を紹介したいと思います。

なお、会社に関する情報は、私の都合である程度、虚実入り混じった情報になることご了承ください。今回の話で伝えたいことに関しては、影響は無い範囲とは思っています。

自分のツイートを「ディープラーニングおじさん」で検索したら、最初に引っかかったのが2016年10月ころでした。もう1年半くらい前ですね。

自分も個人で少しだけディープラーニング試したりしてるので、ディープラーニングおじさんに少しだけ自分の知ってる情報を提供してみたけど、おじさん何も聞かずに特攻しててワロタw でも聞いてばかりで何もしないより全然良いと思う。今度逆に色々教えてもらおう

— からあげ=タベタイナ (@karaage0703) 2016年10月18日

ちなみに、このころの「ディープラーニングおじさん」は、組み込み系のソフトは多少経験がありCが多少は書けるものの、Pythonは当然触ったことなく、そもそもLinuxとUbuntuとC言語とPythonの違いもよく分かっていないという状況でした。

そんな「ディープラーニングおじさん」が、何故か「ディープラーニング」に興味があるということだったので、ちょうど家で「Chainer」使って画像認識のサンプルを動かしていたりしたことなので、簡単なデモを見せました。デモの内容自体は以下記事の延長線上で、リアルタイムにカメラで物体を検出して、それが何かを音声で教えてくれる、的な内容だったと記憶しています。

イメージ的には以下に音声付きという感じでしょうか

こんな感じのデモをした記憶

その後の「ディープラーニングおじさん」の成長は凄まじかったです。正直、最初は環境構築あたりですぐに挫折するだろうと思ってました。

ディープラーニングおじさん、sudoとapt-getを覚えてた。chainerのインストールには成功したけど、お目当のtensorflowはダメだったみたい。もうちょいだね

— からあげ=タベタイナ (@karaage0703) 2016年10月24日

でも、「ディープラーニングおじさん」は諦めませんでした。わずか3ヶ月後。

会社のディープラーニングおじさん、Linuxもpythonも全く分からなかったのに、2ヶ月くらいで画像判別を仕事で活用するまでになって、完全に追い抜かれてしまった。

— からあげ=タベタイナ (@karaage0703) 2017年1月27日

完全に人工知能バカになってて、しゃべる話題も趣味も人工知能で土日もずっとやってたらしい。清々しいほど完敗です

今日はディープラーニングおじさんとディープラーニングのセミナ受講してます。おじさん、講師の本をボロボロになるまて読み込んで臨んでいます

— からあげ=タベタイナ (@karaage0703) 2017年1月27日

セミナで、ディープラーニングおじさんの質問がマニアック過ぎて講師が答えられない事案発生

— からあげ=タベタイナ (@karaage0703) 2017年1月27日

もうここら辺で、完全に見る目を改めました。この人只者ではないなと。さらに、半年の時間が流れます。

休み前に会社で久しぶりに会ったディープラーニングおじさん、NVIDIAのJETSON TX1/TX2を3台ずつ揃えてディープラーニングの実験してた。

— からあげ=タベタイナ (@karaage0703) 2017年8月14日

VRにも興味持ち出してて、HTC VIVEやHoloLensも買ってた。夏休みはUnity勉強するらしい

ここら辺の時点で、完全に完敗です。清々しいまでに完敗しました。いや、ひょっとしたらPythonは自分の方が少しは書けるかもしれないけど、その情熱や姿勢と、ディープラーニングに対する知識量。全てにおいて負けたと思いました。

さらに半年の月日が流れます。会社が「人工知能」というバズワードに踊らされて、怪しげなベンチャーに数千万の投資をしようとしようとしていたとき「ディープラーニングおじさん」が立ち上がります。関係者に地道にデモをふまえて、わかりやすい技術説明からはじめ、仲間を増やしていき。関係者含めた会議をなんどか開き、複数会社のコンペにまで持ち込み「ディープラーニングおじさん」がここぞと思うベンチャー(多分、この分野に詳しい人なら誰もが知っている会社)をコンペにねじ込みます。当初予定していた怪しげなベンチャーは逃げ出し、ついに会社の方針が変わりました。

ディープラーニングおじさん、ついに会社のAIに関する戦略を動かすまでになってた。会社の方針ひっくり返して、今をときめくベンチャーと提携結んでておしっこ漏らしそうになった

— からあげ=タベタイナ (@karaage0703) 2018年3月5日

ここで、「ディープラーニングおじさんはワシが育てた」と言うつもりは、ほんと毛頭、毛先の一本分もありません。私はただきっかけを作っただけですし、もし私がいなかったとしても、多分「ディープラーニングおじさん」は、いつか自分でディープラーニングを知って、同じような道を辿っていたと思います。

どんな丁寧な教育のシステムやチュートリアルがあっても、やらない人はやらないし、やる人はやるのですよね。教育って、本人以外ができることって、きっかけを与えることと、やる気のある人を加速させること、失速させないことくらいなのじゃないかな、って思ったりします。

ここで告白すると、実は私が最初にディープラーニング含む機械学習を勉強し始めた理由って、いきなり会社で「人工知能使って何かしろ!」と言われたときに、反論できるハッタリをかませるくらいの知識が欲しいという、しょうもないネガティブな動機からだったのですよね。でも「ディープラーニングおじさん」が、ひたすらディープラーニングに魅せられ、取り組み、技術に対して目を輝かせ、自分で手を動かし、周囲の考え方も変えていく様子を見て、自分も少しずつ考え方が変わっていきました。今では「もし機会があるなら、ディープラーニング仕事に使うのも良いかもな」と思ったりもします。まぁ使わずに済むならそれに越したことはないのですけどね(笑)

結局、教えられていたのは私の方だったのかな、と今では思います。今度は私の方がきっかけを貰いました。あとはやるだけですね。

私の会社の「ディープラーニングおじさん」の話でした。え、「ディープラーニングおじさん」の今ですか?もちろんGPUガンガン積んだモンスターマシンで、元気にディープラーニングしてますよ(笑)

正直自分の会社で、凄いと思う人はいても、こういう人になりたいって思うことはなくて、常に理想の上司はドラゴンボールのフリーザ様だったのですが、今の理想の上司は「ディープラーニングおじさん」ですね。少しでも深く近づけるように、私もGPUをガンガンぶん回したいと思います(笑)

久しぶりに新しいカメラ機材(レンズ)買いました。

OLYMPUS マイクロフォーサーズレンズ M.ZUIKO DIGITAL ED 12-100mm F4.0 IS PRO

ジャーン

デデーン

感想は「とにかく便利!」の一言ですが、それだけだとあんまりなので、もう少し噛み砕くと以下2点かなと思います。

なんだか、意識高い会社の社訓みたいですね。それぞれ実例をまじえて紹介していこうと思います。

まず「チャンスを逃さない」に関してですが、これの利点は以下2つですね。

私は、Lumix G 20mm/F1.7というレンズを愛用しています。

Panasonic 単焦点レンズ マイクロフォーサーズ用 ルミックス G 20mm/F1.7 II ASPH. ブラック H-H020A-K

このレンズ、小さいし安いのに、写りがメチャクチャ良いのですが、AFが遅い点だけが不満でした。特に子供ができてからは、子供の激しい動きを捉えられず、チャンスを逃したなと思うことも数知れずでした。勿体ないことをしました。

子供がいるとレンズ交換なんて、なかなかできる暇がありません。はっきりいって無理ゲーです。しかたなく遠くのものや近すぎるものをレンズ交換せずに撮ったりするのですが、豆粒みたいになったり、見切れてしまったり…残念な写真ばかりになっていました。

ところがこれのレンズがあれば、もうそんなストレスは一切ありません!AFは爆速ですし、35mm換算で24-200mmという信じられない広い範囲をカバーできるので、レンズ交換の必要がありません。あれ、これ他のレンズいらないんじゃない?って気になってきます。

可能性を広げるというのは、ずばり以下2点ですね。

先ほどの繰り返しになりますが、35mm換算で24-200mmという焦点距離の範囲は驚異的です。

広角を望遠でどれだけ違うか見てみましょう。

一番広角(24mm)の写真

この写真が望遠側(200mm)になると…

こうじゃ!

この広角写真も

こうじゃ!

よくカメラは単焦点レンズで足で稼ぐのが上手くなる秘訣!とか本で読んで

「ふむふむ、望遠ズームとか使う奴は軟弱者だな」

って思ってましたけど、望遠ズームめっちゃ便利です。歩くのとか面倒くさいですね。冷静に考えれば、動かずに色々な画角で撮影できた方がチャンス広がるに決まってますもんね。そりゃオリンピックもドローンで撮影するわけですよ。今まで完全に騙されてました。

実は、このレンズめちゃくちゃ寄れます。

ミクさんの写真、これどれだけ寄っているかというと…

こんだけ寄ってます

別角度。ほぼくっついてます。完全に変態ですね。

何かの間違いじゃ無いのかというくらい寄れるのでビックリです。まさかのマクロレンズまで手に入れた感あります。どんだけ万能なんだ…

あ、ミクさんは以下のやつです

ここまで、良いところばかり書いてしまったので、デメリットも書いておきます。ずばり以下3点です。

高いのとデカイのは仕方ないですね。私は、使ってみてこの性能なら価格もサイズも仕方ないなと納得しました。そもそもこんなスペックのレンズ、他には中々ないですからね。

あと、レンズのF4.0という暗さは、買う前一番気になった点でした。ボケなかったり、暗いところで手ぶれで撮れなかったりしないかが気になっていました。これに関しては、少し補足すると、ボケに関しては、当然ボケにくいのですが、通しでF4.0なので200mmとかうまく使えば、かなりボケを生かした写真が撮れるように思えました。以下の写真とかもそこそこボケ感じられるのではないでしょうか?

あと暗所での手ぶれですが、実はこのレンズはレンズ側にも手ぶれ補正がついているのですよね(ボンクラなので、買ってから気づきました)。ボディーに手ぶれのあるカメラと組み合わせると、非常に強力な手ぶれ補正効果が期待できます。そのため、手持ちでもある程度シャッタースピードを遅くすることで、暗所でもかなり使えそうです。

ただし、カメラとレンズのファームウェアのアップデートは忘れないようにしましょう。ファームウェアをアップデートしないと、カメラとレンズの両方を手ぶれONにすると、より手ぶれ補正ができなくなります(ボンクラなので、最初ファームアップ忘れてました)。

写真をみて、察しの良い方は気づいたかもしれませんが「Peak Design」のストラップも買っちゃいました。

【国内正規品】PeakDesign ピークデザイン リーシュ カメラストラップ アッシュ L-AS-3

「Peak Design」を買ったのは、以下御三方(カメラ御三家)が、皆オススメしていたからです。正直細かいところはあんまり分かってなかったのですが、絶大な安心感がありました。

実際使ってみたら

「あー、自分がずっと欲しかったのこれだわ」

「あの記事で言ってたの、こういうことね。便利だわ」

ってなったので、間違いなかったです。ただ、このレンズのサイズだと、ストラップはもうちょい太いタイプ(スライド)でも良かったかなとも思いました(これは私の判断ミスです)。

しかし、ストラップ買ったら次は、キャプチャープロとか欲しくなるので、完全に危険な「Peak Design」沼ですね。

【国内正規品】PeakDesign ピークデザイン キャプチャープロカメラクリップwith PROプレート CP-2

新しいレンズ「OLYMPUS M.ZUIKO DIGITAL ED 12-100mm F4.0 IS PRO」の紹介でした。やっぱり新しい機材を買うと、撮影欲が高まってきますね。早く写真を撮りに出かけたくてたまらなくなります。

OLYMPUS マイクロフォーサーズレンズ M.ZUIKO DIGITAL ED 12-100mm F4.0 IS PRO

レンズが傷つかないように、合わせてレンズフィルタ(プロテクタ)も買いましょうね(ボンクラなので、最初買い忘れてた)。

Kenko 72mm レンズフィルター PRO1D プロテクター NEO レンズ保護用 撥水・防汚コーティング 薄枠 日本製 127278

【国内正規品】PeakDesign ピークデザイン リーシュ カメラストラップ アッシュ L-AS-3

このレンズでGW(ゴールデンウィーク)お出かけしてきたのですが、本当最高でほとんどこれ一本しかレンズ使わなかったです。そのときの写真は、また今度紹介したいと思います!

ゴールデンウィークは、和歌山に行っていました。お目当はアドベンチャーワールドです。4年ぶりに行きました。

前回は妻と2人で来たのですが、今年はもうすぐ3歳になる娘も入れて3人での訪問です。

というわけで、いつもの通り写真をペタペタ貼っていきたいと思います。今回は使った機材は、買ったばかりの「OLYMPUS M.ZUIKO DIGITAL ED 12-100mm F4.0 IS PRO」です。今回の旅行はほとんどこれ1本しか使いませんでした。

ペンギン

ケニア号というバスでサファリパークを回る

寝ているライオン

あれ何だろうな?と思ったらズーム

お猿さんでしたー

シマウマ

キリン

ペンギンズ

勝手にシロクマ

呼んだ?

イルカショーです。ストーリー性があって、良かったです。

ダイナミックなジャンプ

ジャンプ

イルカに乗った少女

輪っかくぐり

ジャンプ

ジャンプ

ショーの後イルカを見つめる娘

アドベンチャーワールドといえば、パンダです。パンダたくさんいるので、だんだんパンダがインフレしてきてプレミア感が薄れてくるので不思議です。

基本寝てる。この子は数時間ずっとこんな感じだった

アクロバッティックな姿勢で寝ているパンダ

続いて、双子のパンダが外で笹を食べるだけのイベント。ご飯食べるだけでこれだけ注目集める存在はパンダくらいだと思います。

パンダが…

笹食べてる!

可愛いです

笹食べてるだけなのに可愛い

たまに目がくりっとする

なんかジッとみていると、中におっさんが入っているように見えてくるので不思議です。

動物はGIFアニメにしてもめちゃかわいいですね

シロクマ

パンダ

パンダ

今回泊まったのは、前回同様「とれとれヴィレッジ」というドラゴンボールの家みたいな場所です。

ドームハウスに関しては、以前書いたので以下記事参照下さい。

新しくパンダヴィレッジという、めちゃ可愛いドームハウスもありました。こちらは早い時期からの予約必須ですね。中は普通らしいので、外から眺めるだけでもよいかもしれません。

安いけど、ちゃんと冷暖房も完備で部屋の中にお風呂もあります。アドベンチャーワールドまで車で10分。近くには温泉、海鮮の美味しいお店(とれとれ市場)と周辺で観光・食事・お土産が揃う最高の立地です。子供は喜ぶと思いますし、若いカップルや家族連れには良いかなと思います。高級感求めている人には不向きかな。

アドベンチャーワールド行く方は宿泊地の候補にしてみると良いかもしれません。

アドベンチャーワールドに行って来ました。望遠ズームやっぱり便利で、小さい子供を見ながらでも、色々な写真を撮れて良かったです。前回、単焦点レンズと広角レンズだけで撮った写真と見比べると、全然違う写真が撮れたなと改めて思います。

ただ、単焦点や広角レンズという制約の中で足を使って使って撮った前回の写真は、ユニークさがあったなとも思います。まぁでも、こればっかりは仕方ないですね。今回、単焦点と広角レンズだけだったら、小さい子供と一緒ではまともな写真はほとんど撮れなかっただろうなと思います。

OLYMPUS マイクロフォーサーズレンズ M.ZUIKO DIGITAL ED 12-100mm F4.0 IS PRO

あとは、マムートのザックが子供の荷物とカメラを全部入って持ち運びやすくて大活躍でした。

[マムート] リュック Seon Courier 容量:30L 2510-03900 0001 black

カメラのインナーボックスも忘れずに

ETSUMI インナーボックス モジュールクッションボックスD ブラック E-6288

今週のお題「ゴールデンウィーク2018」

身体を楽器にしてしまおうというコンセプトの自作ソフトです。元々の発想は、 YAMAHAさんのTENORI-ON(テノリオン)という楽器を身体を使ってできたら面白いのじゃないかというところから来ています。

昔作ったPV的な動画は以下参照下さい。

昔は、以下の記事で解説したようにKinectを使っていました。

今回は、Kinectを使わず、画像処理にディープラーニングを用いることで単眼カメラだけで実現しています。

自分が遊んでいる例

娘が遊んでいる例。Mac Bookの画面をテレビに映しています

単眼カメラでの骨格検出に関しては、以前以下の記事で紹介しました。

上記記事のソフトでは、GPUのない普通のMacでは処理が遅く、ちょっと楽器として使うには苦しかったのですが、その後リアルタイムに骨格検出できるソフト「tf-pose-estimation」が出てきて「使える!」と思ったので、ゴールデンウィークの休み1日を使って「ヒューマンシーケンサー2.0」として作りました。ProcessingのコードをPythonに移植しています。半日もあればできると思っていたのですが、昔自分で作ったProcessingのコードが我ながら意味不明で移植に思ったより時間がかかってしまいました…

「tf-pose-estimation」をforkして以下のリポジトリを作りました。

詳しいセットアップ方法や、ソフトを作った時の流れ、改造のポイントなどを有料noteに書いてみました。もし「自分も試してみたいけど、セットアップちょっと自信がない」という方や「ディープラーニングのOSSを活用してアプリを作るのって、具体的にどういう風に作れば良いのだろう?」と思った方は購入していただけましたら幸いです。

ソースコードも有料noteだけに書こうかなと思ったのですが、OSSを活用しているのでやはりOSSにもコミットせねばということでソースコードは上記のリポジトリで公開しています。なので、ある程度詳しい人は有料note買わなくても動かせると思いますのでご自由にお使いください。その中で、もし面白いと思ったり、気に入っていただけた方いたら、投げ銭的に購入いただけるととても嬉しく思います。

今回は身体を楽器にするということをやってみましたが、この技術色々応用できそうですね。パッと思いつくところでは、PCと単眼カメラだけでVTuberになるための簡易セットみたいなのを作れそうです。というか4年くらい前(まだVTuberという言葉も無かった頃)に、Kinectでそんなことをやっているので、このソフトを移植すればできそうです(頭の中では出来てる)。

多分1日頑張れば作れるので、需要があれば作ってみようかなと思っていたのですが、Twitterであんまり反応無かったので多分作らないかな…もし20人くらいから反応あったら作りますのでtwitterやコメントで教えて下さい。

昔Kinectで作った以下のようなアプリも、ディープラーニング使うとPCと単眼カメラだけでできそうです。

最近、紙の本はほとんど買わなくなり、電子書籍を買うようになりました。最近といっても、もう5年以上は経っていますが。理由は特に書くまでもない気がしますが、私の場合は以下のメリットが大きいです。

デメリットも無くは無いですが、メリットの方が十分大きいので、基本的に電子書籍を購入しますし、購入したい書籍に電子書籍が無い場合は、電子版が出るまで待つか、買うのを諦める場合が多いです。

ちなみにまだ10年くらい前、電子書籍まだ普及してなかったころ未来の電子書籍事情を予想した記事が以下です。

今となってはどれも当たり前のことばかりですね。でも、10年くらい前はそれが想像できない人が多かった記憶があります。よくわからない理由で、電子書籍を固くなに否定していた人は、まだ紙の本を読んでいるのでしょうか?

そして電子書籍の普及自体は、予想通りだったのですが、予想外だったのは電子化することで、自分の本の読み方が変わったということです。

変わったなと感じる点は、具体的には以下です。

昔は、基本的に1冊(前後編とかは別)買ってその本を読み終わるまでは、違う本を読むことは無かったのですが、電子書籍だと以下の記事でも書いたように2冊とか3冊の本を平行に読んだりすることが凄い増えました。 karaage.hatenadiary.jp

当然、本を同時に買うことも当たり前になりました。

1日に違う分野の本を3冊くらい買うときも

結局、今まで紙の本という物理的制約に無意識に読み方を縛られていたのに気づいていなかったのですね。電子化という技術によって、初めてその不自由に気づかされたのです。複数の本をザッピングしたり、隙間時間に本を読むって、なかなか紙の本ではできないですからね(物理的に)。

あと、電子書籍が「あの文章が書かれてたのどこだっけ?」と思ったとき検索できるというのは非常に大きいですね。

電子書籍を読むようになって、本の読み方が変わったことに今更ながら気づいたという話でした。こういった、物理的制約に無意識に縛られていることって、他にもきっとたくさんあるのだと思います。そういった制約を技術でどんどん解放していきたいですね。

例えば、人の手が2本だったり、指が5本だったりって大きな物理的制約ですよね。指を3Dプリンタで増やす試みとかありますが、人間の肉体もどんどん拡張しちゃった方が良いのじゃないかなと思います。例えば、人間が十進法を使うのは、指が10本だからのようですが、指が16本だったら片手で1Byteになるのでコンピュータとはかなり相性が良さそうです。

また、肉体を拡張すると、脳も一緒に拡張していくことになるはずで、実は潜在能力的なものを発揮できたりする可能性もあるのじゃないかな、とか思ったりします。私は、指も腕もあと2本くらい生やしたいし、透視能力のある目も欲しいし、定期的にヤバイ脳内麻薬ドバドバ出るような脳みそ欲しいですね。

と、この記事実は1ヶ月くらい前に書いたものなのですが、ここ最近、書籍関係でなかなか面白い流れが起こっているので、珍しく続きとして、来週月曜はそのことに関して取り上げてみようかなと思います。

前回、以下のように書籍のデジタル化に関しての話をしましたが、今回は出版業界のソフトウェア化の話をしたいなと思います。

最初に断っておきますが、私は特に出版業界に詳しくないですし、出版社に対して特に恩義も恨みもないフラットな立場です。

最近、同時多発的に色々な方面から出版社への不満や危機を指摘する話をよく聞くので、それらを整理して自分なりの業界予想的なものをまとめてみたという形です。特に「出版社はこうすべき!」という熱い思いがあるわけでは無くて「まぁ、このままいけばこういう方向かな?」と私が感じた傾向を書いているだけの内容となります。

今回の記事書くきっかけになったのは、GOROmanさんのマッハ新書です。詳細はねとらぼさんの以下記事参照下さい。

私も第一弾の「全ての出版社は多分潰れる」というロックなタイトルの書籍を買いました。「12時間で書く」とか「誤字が多い」とか「校正がちゃんとされてないのに価格とって酷い」といったところが変にフォーカスされているようですが、マッハ新書の重要な点は、GOROmanさん自身がおっしゃっているように、ソフトウェアの開発プロセスを書籍の執筆に取り入れたというところと、それによって1つのムーブメントが起きたということなのじゃないのかなと個人的には思っています。

マッハ新書に関するTwitter上での議論は以下にありますが、重要な指摘と本質を捉えてない(と私が思う)指摘がごちゃまぜの印象です。

まあ、当の本人はマッハで飽きていますw

もう飽きたw https://t.co/ZAMA0awEij

— GOROman@うにてぃー登壇 (@GOROman) 2018年5月9日

マッハ新書は、マッハストレスフリーZXに改名したらしいですが、マッハ新書ってネーミングは個人的には絶妙だったと思っています。

自分が知る限り、作家でありながら最も早く出版社に対して危機を指摘したり苦言を呈していたのは森博嗣先生だったと思います。2010年に出版された「小説家という職業」で、出版社に対してかなり辛辣な指摘をしています。これを8年も前に紙で出版するという森博嗣先生も凄いですが、逆に言えばもう2010年頃から出版社の力が弱まっているということかもしれません。もっと出版社が強い時代だったら、この内容は絶対紙の書籍にはならなかったでしょう。

森先生は、出版社に関しては、他にも「作家の収支」や「読書の価値」といった本でも触れています。

なおTwitterで教えてもらったのですが森先生は7年前に「科学的とはどういう意味か」という本を3日間に分けてではあるものの、マッハ新書と同じ12時間で書き上げたらしいです。全然違うタイプなのに、GOROmanさんと出版社への指摘含め重なるところが結構あるのが非常に面白いと思いました。

なお、2人とも共通している出版社への意見は、出版社は変わる必要があるし、変わることができることができればチャンスがあると言っている点です。この点に関しては、森先生は最近の書籍で「もう手遅れ」と断じているので、どちらかというと森先生の方が厳しい指摘ですね。まあ、GOROmanさんも同じことを思っていそうですが。

モーリス・ルブラン原作の「アルセーヌ・ルパン」を『怪盗ルパン伝アバンチュリエ』として漫画化している森田崇先生は、Twitterでこんなことをつぶやいていてビックリしました。

先日印税5%の仕事を某大出版社の某大雑誌の編集長からふられたのですが、途中で印税率交渉をしたら、呼び出されて「印税は漫画家が口を出すことでは無い」と言われ、30秒で決裂しました。そこまでの作業のギャラも当然ナシ。ちなみにKindleは印税70%です。もう付き合ってられませんね https://t.co/GGk9klCQ4g

— 森田崇@怪盗ルパン伝アバンチュリエkindle版配信中 (@TAK_MORITA) 2018年5月6日

印税って基本10%と思っていたのですが、印税5%で交渉もできない…もちろん全部の出版社がそうではないでしょうが、あまりに酷いですね…ちなみにBOOTHとうサービスを使うと手数料が3.6%なので、印税96.4%です。印税と手数料の逆転現象…

ちなみに森先生は、印税は出版社と交渉していると何度か公言なさっていますし、具体的な数字も出していますね。

参考:

機械学習の世界では、最近は正式な論文誌に載せる前に arXiv というフリーの論文投稿サイトで論文を公開するという流れが発生しています。最新の研究では、研究の進歩のスピードが速すぎるため、論文誌の掲載より即時性のあるarXivの方が注目を浴びるという、ある意味権威の逆転現象が起こっています。Nature紙も、有料の機械学習専門論文誌をやるといって、「ハゲタカビジネス」と叩かれているようです。

また、機械学習の本では、執筆中の本をドラフト版として無料公開して、読者からフィードバックをもらうという試みが増えつつあります。 「Machine Learning Yearning」とか「ゼロから作るディープラーニング2」もそうですね。

読者は、早く本を無料で読めるし、作者はフィードバックを貰えるという関係ですね。無料でレビューした読者も、内容が良ければファンになって、本も結局買ったりするという好循環が起こるのじゃ無いかなと思います(もちろんうまくいかないケースもあるでしょうけど)。

こういった、権威の逆転現象とか、β版公開してのフィードバックとかはまさにソフトウェアの世界での話で、マッハ新書と通ずるところがあると思っています。

特に公開して、多くのプロ以外を含む一般人からフィードバックをもらって製品を修正していくという流れは、正にOSS(Open Source Software)開発と同じプロセスですね。出版社のプロの編集者による校正無しで、本当に書籍としてのクオリティが保てるのか?という議論は、まさにプロプライエタリなソフトウェアとOSSの開発手法を分析した「伽藍とバザール」の内容をなぞっているようで中々興味深かったです。「伽藍とバザール」は以下で日本語訳が読めますので、興味ある方はご一読下さい。短めですので、サクッと読めます。

The Cathedral and the Bazaar: Japanese

また、開発手法という点では、一部のウェブ出版では、以下のようにGitHubを活用した編集が行われているらしいです。これはある意味企業のOSS活用と捉えることもできそうですね。出版業界でこのようなことをできる人がどれだけいるのかは分からないですが。

書籍のデジタル化によって、出版社の競合として出版社以外の流通の方法が増えたというのも重要な点ですね。Kindleは印税70%という話がありましたが、noteなら85%程度(条件により変動)、BOOTHなら96.4%です。音楽と一緒で、もう本が大量に売れるという時代でもないので、こういったサービスでニッチを狙っていった方がある意味健全なのかなという気もします。

例えば出版社の印税が森田先生が提案受けた5%として、1000円の本を売ったとすると1冊あたり50円。今や2,3万冊でベストセラーというくらいらしいので、50円x2万で100万円。たとえベストセラーになったとしても100万円です。

一方、GOROmanさんは、BOOTHで1330冊売ったらしいので、1000x0.964x1330=128万円

おかげさまで電子書籍はトータルで1330冊ほど売れました!ありがとうございます。

— GOROman (@GOROman) 2018年5月7日

紙の本はアナリティクスとかレポートが無いのでどれくらい売れたか消化率とか全然わかりませーんw

なお、GOROmanさんはマッハ新書で得たお金、全てを自分以外のチャレンジしている方への応援に使っています。凄い!

BOOTHの最初の本は全てのTODOさんに二作目は得たお金でOculus Goを買えるだけ買って若い学生さんに送ります。ターゲットが若い人な理由は単に歩留まりとチャンスです。

— GOROman (@GOROman) May 11, 2018

もちろん、紙の書籍でベストセラーになるということに、お金以上の価値を見出す人も多いとは思いますが、そういう人の割合も今後どんどん減っていくのかなとは思います。

また、noteやBOOTHだと、自分で企画から営業まで全部やらないといけない(コンテンツ制作だけやればよいわけではない)辛さはありますね。逆に言えばこれらができる人は今後は出版社を必要としないのだろうなと思います。

これらの流れって、GOROmanさんが言っていたように「出版業界がソフトウェア化している」ってことなのかなと思います。マッハ書籍のムーブメントも、その流れがたまたま大きく顕在化しただけで、マッハ書籍は収束したとしても、このような流れは今後何度も起こるのだろうなと思います。マーク・アンドリーセンが「Why Software Is Eating the World」というエッセイで言ったように、あらゆる業界はデジタル化、ソフトウェア化していくのじゃないかなと思います。

マスに向けた本の需要とまだありますし、当分は住み分けは可能と思いますので、出版社もいきなり潰れることはないとはないと思いますが、このままいけば徐々に衰退していくのかなという印象です。テレビとネットの関係にも似ているかもしれませんね。

自分自身はというと、人工知能で今まで1度も書いたことない小説書いて有料noteで販売していたりするので、ある意味マッハ新書と別のベクトルでヤバいかもしれませんね。

GOROmanさんの #マッハ新書ちゃんと校正してないものを価格付けて売るなんて言語道断みたいなこと言っている人がいるらしいけど、よく考えたら人工知能で小説書いて有料noteで販売している自分はもっとやばいんじゃないかという気がしてきた。反省しました!もっと買って!https://t.co/s2wOfld6oy

— からあげ=タベタイナ (@karaage0703) 2018年5月9日

以前、フィルムカメラのデジタルバックをRaspberry Piを使って作っていました。

このデジタルバック、Ogaki Mini Maker Faireでも出展をしたのですが、そのとき2,3人の方からいただいたコメントが「ゼンザブロニカを使うとよいのじゃない?」というアドバイスでした。

ずっと迷っていたのですが、もう買うしか無いと意を決して覚悟を決めるためにTwitterで呟いたら

よければ、貸しますよ〜〜

— カトウタクミ( ˆᴗˆ ) (@tako3) 2017年9月5日

ネット凄い…

というわけで、お借りして良い感じだったので、市場価格で買取りさせていただきました!

というわけで、こいつをデジカメ化していきます!名付けて「ZANGI BRONICA(ザンギブロニカ)」

ZENZA BRONICA(ゼンザブロニカ)

ヤフオクとかフィルムカメラショップで買いましょう

3Dプリンタ

いまや、どこのお家庭にも1台はある3Dプリンタです。「UP Plus2」がオススメ。詳しくは以下です。

Canon フォーカシングスクリーン Eg-S SCREEN-EGS

これまじ最高です

とりあえず適当にコンセプトを図面っぽいものにします。

あくまで図面っぽいものです。じっくり見ないで!

適当に作りすぎて、何度も作り直すハメに…メカは苦手なんです…

図面ができたら、3D CADでCAD設計します。「Fusion 360」を使います。詳細は以下参照下さい。

適当に押し出してたら完成しました。

出来上がり(2パーツのうちの1つです)

CADデータができたら、3Dプリントします。Normalクオリティでも6時間かかる大作です

でかい…

こいつを…

こうじゃっ!!

そしてフォーカシングスクリーンを

傷つきやすいのでソーッと

こうじゃ!

実は、ちょっと傷ついてしまって泣きそう

次は、ふたの部分です。以下のようなものを3Dプリントします

ちょっと削ったのは内緒

以下のようにRaspberry Piカメラを取り付けます

裏側には、Raspberry Piとディスプレイを取り付けていきます

あれよあれよという間に、Raspberry Piとディスプレイがくっつきました。

プロトタイプの出来上がりです

正面図

起動

起動

ソフトは、以前作った「変デジカメラ」のソフトをほぼそのまま使いました。

カメラでカメラを撮るテスト

トリミングしてあります。なかなか雰囲気ある写真が撮れている気がします。

ちなみにフォーカシングスクリーンが重要で、Eg-Sでなく、Ee-Aというものを使ったときは、下記の写真のようにうまく全体に光が拡散しませんでした。

ここらへんは、理屈がイマイチわからず、あんまり納得いってないのですが、現状はお金で解決バイヤイヤイ状態です。

中判フィルムカメラをRaspberry Piを使ってデジタルカメラ化する「ZANGI BRONICA(ザンギブロニカ)」のプロトタイプを作りました。今後、もうちょっとスタイリッシュにしたいなとか(できれば、もとのフィルムバックくらいのサイズに収めたい)、色々写真を撮りたいなとか、撮影した写真を使ってxxxして(エロい内容ではないです)とか、色々あるのでじっくり取り組んでいきたいなと思います。

何か新たに面白いことできたら、今後ブログでもその1部を紹介しようと思います!

http://labo.turtleback.hk/friends-diy-dof-adapter-and-transparency-paper-for-focusing-screen/

全然このブログで書くようなことでは無いのですが、妻からどうしても拡散してほしいというリクエストがあったので書きます。

「karaage.」の半分は、妻への優しさで出来ています。

それではご覧ください。「貝(あさり)の裏を箸でコチョコチョすると貝柱がめっちゃ綺麗にとれる動画」です

私も昔テレビで見たような記憶があるので、知っている人も多いと思いますが、知らない人は知らないでしょうね(当たり前)。こういう「そもそも調べることすら思いつかない知識」ってどうやってアップデートするのが良いのでしょうね?あんまり思いつかないので、こうやって不定期に誰かが色々な場所で発信することは少しは世の中の役に立っているのかもしれませんね。

ちなみに、なんで貝柱が綺麗にとれるのか調べてみたけど良く分かりませんでした。摩擦熱って書いてあるところありましたが、そもそも貝って十分熱せられているような気が…

というわけで、短いですが今日の記事はこれでお終いです。たまには「箸休め」ということでご容赦ください、おあとがよろしいようで(笑)

いつものように、何気なくTwitterをしていたら悪魔のようなリプライが飛び込んできました

マレーシアもよさそうですがミニチュアダックスのランディーくんが気になる今日この頃です。 pic.twitter.com/IeOpHvUyvl

— ろんすた (@monestar) 2018年4月22日

ほ、ホゲ〜〜〜!これはネットの海の藻屑と化したはずの自分の黒歴史…いったいどこでこんなものを…

ネットストーカーなので初期からあげをチェックしてます。めっちゃ面白いですw pic.twitter.com/iHojb53MuM

— ろんすた (@monestar) 2018年4月22日

ろんすた…恐ろしい子…

なんでも、消え去ったはずのWebサイトを見れるようにするという悪魔のようなサービスがあるらしいですね。情弱なので知らなかったです。嘘です。気づかないふりしてました。

初期からあげヘッダー画像詰め合わせです。 pic.twitter.com/onIUcTjwxA

— ろんすた (@monestar) 2018年4月22日

もうやめてーーー!!

というわけで、今日は特別に「karaage.」がまだ「KARAAGE」だったころ(昔は大文字で末尾のピリオドも無かったのです)の記録を特別公開して特別後悔したいと思います。18年とか前だぜ…

当時のデザインも含めて紹介するため、スクリーンショットでの公開です。文字が読みにくいですがご容赦下さい。というかしっかり読まないで下さい。危険です。

2000年とかに公開してたサイトですね。当時はHP(ホームページ)という言い方の方が一般的だった記憶があります。

これ、さりげなく酷いですね。色々な意味で。

このころは、家のPCで自宅サーバを立てて、2ch風掲示板を運営していました。日記は、自分で2ch風掲示板に日記のスレッドを立てて書き込みしていくというブッ飛び仕様でした。当然誰でも書き込めてしまうので、知らない人が勝手に日記を書き始めたりとカオスな様相を示していました。掲示板の方のログ残ってなくて本当に良かったです。詳細は以下参照下さい。

この頃は、自宅サーバにtdiaryというフリーのWeb日記のソフトを入れていたと思います。う、うう。記憶が… ちなみに「はてなダイアリー」のベースはtdiaryですね。なんだかとんでもないこと書いてます。

そして…でたーーー!「BLEACH」(ブリーチ)の久保帯人先生も全裸で逃げ出す思春期ポエム!

YABA過ぎる!!

このころは、自宅サーバにMovable Typeというブログソフトを入れていました。このころブログという呼び名が流行りだした記憶です(もっと前かな?)。今だとWord Press等の優れたソフトがありますが、この頃はMovable Typeほぼ一択でした。

唐突な放送禁止用語

確かこのころバンドやっていたのですが、多分、セックス・ドラッグ・ロックンロールしか考えてなかったです。

ど、ドラゴンボール…?

クリスマスに置いてあった謎画像…(元画像はモザイク無しです)

こうやってみると、ネットは変わったし、自分も変わったなと改めて気づかされます。

今から10年以上前のネットって、今と違ってごく一部の人しか使ってなかったですし、わりと無法地帯な感じだったのですよね。例えるなら、世紀末の荒野を肩パッド入れたモヒカン雑魚がバイクで爆走しているイメージです。

こんな感じね

でも、10年以上の時間がたって、荒野だった場所は舗装されたアスファルトになり、スーツを着た人があふれかえり、信号といった交通ルールが整備されて、警察や手斧を持った自警団が増えて…そんな中に、肩パッド入れたモヒカン雑魚がバイクで爆走してたら当然奇異の目で見られますし、ルールを無視したら取り締まられてしまうわけです。モヒカン雑魚にとっては、ルールがなかった時代と全く同じことやっているだけなんですけどね。でも、それがネットがインフラになったということなのだと思います。

こんな感じね

私も変わりました。昔は「明日死んでもいい」と思いながらブログをやっていましたし、PV数や金を稼いでるようなブログはクソだと思って、当時のセオリーを全て無視してブログを作っていました(「からあげ」というエゴサーチ不可能な名称はその名残です)。

でも、私も結婚して家族ができ、精神的にも体型的にも丸くなり、気づいたらレンズ欲しさに有料noteに手を出すまでに堕落してしまいました(世の中金だ)!

昔の文章見ると、あまりの酷さに笑ってしまったり、恥ずかしい部分もあるのですが、「こんな勢いのあるパンキッシュな文章、自分にはもう書けないな」という寂しさもあります。黒歴史って書きましたけど、昔の自分の文章って、私にとっては大切な思い出です。ネットに文章を書くというのは、全てログが残ってしまう怖さもありますが、思いがけず昔の自分と向き合える貴重な機会でもあります。今回も、ブログを書き始めた頃の熱い初期衝動を思い出させられました。

ネットがインフラとなった今では、ブログで多くの人が不快な思いをするようなこと(下ネタとか)を好き勝手に書くことは出来なくなってしまいましたが、たまにはあのときの初期衝動を思い出してブログを書きたいなと切に願います。

こんなブログですが、読者の皆様が不快にならないように最新の注意を払い、良質なコンテンツを届けていきたいと思いますので、みなさまもどうか今後ともよろしくお願いいたします。

餃子1日100マンコ!

Intelが出したAIに特化したプロセッサです。これをつければ、Raspberry Piでもサクサクとディープラーニングでの画像認識が動くという優れものです。「欲しいなぁ」と思い悩んでいたら、ディープラーニングおじさんがポイっとくれたので、早速夜中に家でゴソゴソ試してみました。

Movidius Neural Compute Stick - NCS ニューラル ディープラーニング USB スティック

また、カメラは、Open CVから呼び出しやすいUSBのWebカメラを使います。私が使ったのは、以下ですが多分どの機種でも大丈夫だと思います。

【2012年モデル】ELECOM WEBカメラ 200万画素 1/5インチCMOSセンサ マイク内蔵 コンパクトタイプ ブラック UCAM-C0220FBBK

ネットに情報も出回っていたので楽勝だと思っていたのですが、案の定色々詰まったので自分へのメモとしてセットアップ方法残しておきます。誰かの役に立つことを願います。

ディープラーニングではいつものことですが、バージョンが重要です。特にncsdk(MovidiusのSDK)とTensorFlowとKerasのバージョンは超重要です。うまく動かない場合は、バージョンダウンする勇気(?)を持つことも大切かもしれません。

今回は以下のバージョンでセットアップしました。

python==3.5.3 ncsdk==1.12 tensorflow==1.4.1 keras==2.1.2 opencv==3.4.0

主な流れは以下です。

使用するOSはRaspbian StretchでOKです。てっきりUbuntu入れないとダメだと思っていたのですが、Raspbian Stretch Desktopに正式対応したみたいです。Raspbianのセットアップに関しては下記記事参照下さい。

注意点としては、以下2点です。

偉大なる先人の知恵に感謝です。スワップファイルは、上記の記事では1GBに設定していますが、成功している人は大体2GBの設定にしているようだったので、以下のとおりに設定しました。

CONF_SWAPSIZE=2048

以下のとおりコマンド実行してインストールします。TensorFlowはバイナリパッケージを使うので、10分もあればインストールできます。Kerasは、Intel Movidiusには対応していないので、入れなくても良いです(今回は、Intel Movidius無しの場合との比較に使うために入れています)。

$ pip3 install numpy==1.13 $ sudo apt-get install libblas-dev liblapack-dev python3-dev libatlas-base-dev gfortran python3-setuptools $ sudo pip3 install https://github.com/lhelontra/tensorflow-on-arm/releases/download/v1.4.1/tensorflow-1.4.1-cp35-none-linux_armv7l.whl $ sudo apt-get install python3-h5py $ sudo pip3 install keras==2.1.2 $ pip3 install -U numpy

インストールできたかの確認は以下のようにライブラリをインポートして確認しましょう。

$ python3 Python 3.5.3 (default, Jan 19 2017, 14:11:04) [GCC 6.3.0 20170124] on linux Type "help", "copyright", "credits" or "license" for more information. >>> import tensorflow /usr/lib/python3/dist-packages/h5py/__init__.py:34: FutureWarning: Conversion of the second argument of issubdtype from `float` to `np.floating` is deprecated. In future, it will be treated as `np.float64 == np.dtype(float).type`. from ._conv import register_converters as _register_converters >>> import keras Using TensorFlow backend. >>>

上記のようにエラーでなければOKです(warningは出ますが、無視して良いそうです)。

以下コマンドでSDKをインストールできます。3行目は実行するとビルドが始まり、終わるまでに4時間くらいかかります。リモートだと切断してしまう可能性があるので、Raspberry Pi本体のターミナルで実行するのが良いでしょう。byobuなどの仮想端末使っても良いかもしれませんね。

$ git clone http://github.com/Movidius/ncsdk

$ cd ncsdk

$ make install && make examples

参考サイトによると、Intel MovidiusのSDKをインストールすると、一緒にOpenCV3のインストールされると書いてありましたが、そんなことは無かったです。SDKのリポジトリに./install-opencv.shというファイルがあるので、このスクリプトを実行してインストールするように仕様が変わったのかもしれません。

ただ、OpenCVビルドをRaspberry Piでやるとまた数時間かかってしまうので、今回は以下コマンドでバイナリパッケージでインストールしました、。ものの2,3分でインストールできます。

$ wget https://github.com/mt08xx/files/raw/master/opencv-rpi/libopencv3_3.4.0-20180115.1_armhf.deb

$ sudo apt install -y ./libopencv3_3.4.0-20180115.1_armhf.deb

$ sudo ldconfig

Intel Movidiusがちゃんと動くか確認します。以下実行します。

$ cd ~/ncsdk/examples/tensorflow/inception_v3

$ python3 run.py

以下のように electric guitar が認識されればOKです。

Number of categories: 1001 Start download to NCS... ******************************************************************************* inception-v3 on NCS ******************************************************************************* 547 electric guitar 0.9883 403 acoustic guitar 0.00772 715 pick, plectrum, plectron 0.001509 421 banjo 0.000926 820 stage 0.0006595 ******************************************************************************* Finished

まずは、Intel Movidius無しの状態で試してみましょう。

Intel Movidius無し

試すのは、以下と同じ内容ですね。

以下コマンド実行すると、画像認識が動きます。

$ git clone https://github.com/karaage0703/tensorflow-pi

$ cd tensorflow-pi

$ python3 inspect_camera.py

あくびが出るくらい遅い(2倍速程度の速さです)

次にIntel Movidius有りの状態で試してみましょう。

Intel Movidius有り

Intel Movidius有り

以下コマンドで、@pon_datさん作成のスクリプトをダウンロードします。

$ cdcd ~/ncsdk/examples/tensorflow/inception_v3 $ wget https://gist.githubusercontent.com/PonDad/bc185bdf81735dfd018bda6ce0b37fea/raw/85652b5b2b03dd6c37fc5b5de220546d431be444/app.py

以下実行すると画像認識が動きます。

$ python3 app.py

めっちゃ早い。というか認識速度にカメラ表示がついてこれない感じ(2倍速程度の速さです)

Intel Movidiusを使ってRaspberry Piで画像認識を試してみました。Intel Movidiusで画像認識自体はかなり高速化されましたが、カメラの表示など他の部分がついてこれないので、使いどころは限られてきそうだなという印象です。また、高速化のためにはモデルの変換や、プログラムの修正が必要で、USBを刺したら自動的に高速化というわけではないので注意が必要です。ここらへんはハードウェアのアクセラレータなので、当たり前といえば当たり前なのですが、普通のPCでのGPU使用の有無のようにもっと簡単に切り替えられると楽なのになと思いました。

Intel Movidiusを使えば、ラズパイで高速に「ヒューマンシーケンサー2.0」を動かせるかなと目論んでいたのですが、ソフトを変更するのが中々大変そうなのと、映像表示などの部分がボトルネックになりそうなので、一旦ペンディングしたいと思います。

Movidius で画像認識高速化 for ラズパイ | AI coordinator

MovidiusをRaspberryPi3で動かしてみた(執筆途中) - Qiita

Raspbian Jessie+ROS Kinetic+samba4.2.14+Python3.4.7+Tensorflow1.3.0+Keras2.1.2+OpenCV3.3.1+Jupyter Notebook+Single Shot Multibox Detector(SSD)環境の構築 - Qiita

Accessing the Raspberry Pi Camera with OpenCV and Python - PyImageSearch

GWに和歌山旅行に行ったのですが、その帰り串本という町に寄ったときに「トルコ姉妹都市」という文字の看板を見かけて気になっていました。実は私の新婚旅行先がトルコだったりするのですよね。

後で調べたら、串本町がエルトゥールル号遭難事件のあった場所だということを知りました。エルトゥールル号遭難事件というのは、簡単に話すと、難破したエルトゥールル号という船に乗っていたトルコ人を日本人が助けたという話なのですが、事件から95年後、イラン・イラク戦争のときの日本人救出劇にトルコ国家が協力したという後日談含めて、トルコと日本の友好を示す感動的なエピソードなので、知らない方は是非Wikipediaなど是非一読下さい。

新婚旅行のツアーで、トルコ人のガイドさんが、旅行の最後に話してくれたのがこのエルトゥールル号の話でした。陽気な方でしたが、このときは静かに、熱く語っていた覚えがあります。「トルコの教科書にも載っていて、トルコ人の誰もが知っている話」と語っていました。

もちろん、トルコ旅行のツアーのガイドさんなので、リップサービスもあると思いますし、流石に今はトルコ人の全員が知っているわけではないと思いますが、それらを差し引いても「エルトゥールル号」の話は、トルコでの認知度に対して日本の認知度が低いと感じているので、少しでも周知に繋がればと思い紹介させていただきました。

トルコというとどのような印象でしょうか?豪華なモスクでしょうか?ケバブでしょうか?

では、そこに住むトルコの人はどんな人たちでしょうか?トルコアイスでお客さんをおどかす陽気なトルコ人でしょうか?ターバンを巻いたよく分からない人でしょうか?

田舎の方のトルコ人は本当に素朴な方ばかりで、外国人が珍しいらしく、子供たちがキラキラした目で「一緒に写真を撮って欲しい」と身振り手振りでツーショット写真を頼む姿が印象的でした(妻がツーショット写真撮られていました)。

もちろん、トルコアイスで遊ぶ陽気なトルコ人もいました(笑)

グランドバザールのトルコ人の商売人は「ゼンブタダ(全部無料)!」と叫んで日本人を呼び込んでいました(笑)

カッパドキアの気球ツアーでみた光景は、一生忘れられないでしょう。

トルコの平均寿命って日本よりかなり短いらしいです(旅行の時は60歳と聞きました)。お金の計算も適当で、お店で買っても細かいお釣りは出てきません。みんなお釣りを払わなければトータルでOKっていう考え方みたいです。そんな適当だと、なかなかビジネスうまくいきそうにないですね(笑)

でも、どのトルコ人も陽気で楽しそうでした。トルコ人のガイドさん曰く、多くのトルコ人にとって、日本は小さい島国にも関わらず、SONY、TOYOTAなど世界に名だたる企業があり、飛躍的な経済成長を遂げている憧れの国らしいです。

確かに日本はトルコより経済の規模が大きく、平均寿命も長いですが、トルコ人と日本人どっちが幸せな人多いのかなと、陽気に笑うトルコ人の姿をみながら少し考えてしまいました。

串本町には、橋杭岩(はしぐいいわ)という奇妙な岩が立ち並んだ場所があります。

トルコのカッパドキア周辺にも、奇妙な岩がたくさん並んでいたので、既視感を覚えました。

エルトゥールル号に乗っていたトルコの方も、日本でこの岩を眺めて祖国を想ったりしたのでしょうか?奇妙な岩を見ながら遠いトルコのことを思い出しました。

トルコと日本の友好って、遠くの国で接点がなくて、お互いのことを良く知らないからうまくいったという側面もあるのだと思います。例えばもっと近くの国だと、同じような事件があったとしても、様々な利害関係が生じて長く友好関係を築くことは難しいのだろうなと思います。でも、だからこそお互いを助け合い、尊敬し合うことのできる貴重な関係は、できる限り続いて欲しいなと1人の日本人として願っています。

2万円台で購入できるVRゴーグルです。気付いたら買ってしまっていました。

Oculus GoやVRの世界で起きていることの概要などは、以下の記事を参照下さい。

私個人としては、日本にOculusを広める立役者となった、VRエバンジェリスト@GOROmanさんの影響が大きいですね。以下の本もオススメ…と言いたいのですが、Amazonでめちゃめちゃプレミア価格になっていますね…

ミライのつくり方2020―2045 僕がVRに賭けるわけ (星海社新書)

まだOculus Go購入して1週間ほどですが、色々便利な使い方とかコンテンツが分かってきたので、簡単に紹介します。この記事はしばらく随時更新していく予定です。

公式サイトでクリックするだけ!なのですが、たまに聞かれるので一応書いておきます。

以下の公式サイトに行きます。

ちゃんと日本語で表示されます。右上に「購入」ってボタンがあるのでクリックします。32GBか64GBか聞かれるので、漢なら64GBをクリックしましょう(笑)

あとは、クレジットカードかPayPalで購入できます。以下の画面が出たら購入完了です。

海外からの輸送になりますが、特に支払った以上のお金が追加で必要ということは無いようです(多分。無いと信じてます…)。

注文すると、4日ほどで到着します。Twitterみてると、ほとんどの人が注文から1週間以内に受け取っているようです。

Amazonでも販売していますが、今のところぼったくり価格なので公式から買うのがよいでしょう。リンクもここからは貼りません。

説明の必要ないほど簡単ですが、一応ブロガーの端くれなので書いておきます。

こんな感じの箱がくるので開けます

コントローラ(リモコン)に付属の電池を入れます

コントローラにストラップを通します

完了!

ソフトウェア的なセットアップは、スマホに専用のアプリを入れて行います。アプリが親切にガイダンスしてくれるので、恐らくOculus Goを買う人なら詰まることは無いかと思いますが、自信ない人は以下の記事参照下さい

Oculus Go、開封からセットアップまで完全ガイド | Mogura VR - 国内外のVR/AR/MR最新情報

眼鏡着用の場合は、スペーサーを取り付けると良いらしいのですが、私の場合はそのまま使えたので取り付けませんでした。スペーサーの取り付け方は、マニュアルは分かりづらいので、以下の記事を参考にするのが良さそうです。

眼鏡っ子のためのOculus Go:眼鏡スペーサーの取り付け方法 - デイビッドのキャンプ

自分で試してみて良いなと思ったコンテンツ情報です。順番は特に優劣ないですが、上から順に試していくのが良いかな、というくらいの気持ちで並べています。有料のものはタイトルに有料と記載しています。

まだまだ全然試せていないので、色々教えて欲しいです。

ありきりですが、ブラウザでYoutubeとかAmazon Primeビデオ見るだけでもう凄いです。Amazon Primeビデオとか全画面で見たら、ほんと映画館ですね。

Youtubeだと、とりあえずPerfumeの「Everyday」あたりが良いでしょう。

ボカロ好きなら以下あたりのリンクから見てみると良さそうです。私も気になるものを順に見ています。

Oculus Goで見たいお薦めボカロVR動画10選+α|NAT(ナット)|note

Amazon Primeビデオに関しては「見れない!」「操作性悪くて使えない!」という声が聞こえるので、不安に思っている方も多いと思いますが、この後の「便利に使うTIPS」のところで紹介するテクニックを使うと、劇的に操作性良くなるので是非試して見て下さい。

VRで全画面表示すると完全に一人映画館です。

VR空間でチャットができます。一回だけ試しましたが、実在感(すぐそばにいる感)が半端ないですね。おしゃべりだけでなく、一緒にゲームしたり、動画みたり、音楽聞いたりもできます。GOROmanさん曰く、RoomsでオセロしてないとOculus Goの9割の力を発揮できていないらしいです(笑)

VR空間でのオセロ

「めちゃめちゃファンキー」と言われる私のアバター。ボボボーボ・ボーボボっぽい

これは普通にビジネスでも使えそうだなと思いました。スカイプとはまた一つレベルの違う感覚です。

Roomsに関しては、以下の記事も参考ください(ちょっと熱量多めです)

Oculus Goのことを人類はもっと真剣に考えるべきかもしれない :情熱のミーム 清水亮 - Engadget 日本版

ASCII.jp:Oculus GoのRoomsはなぜ凄いのか?|遠藤諭のプログラミング+日記

ディズニー提供の無料VRコンテンツです。短めですが、凄いクオリティ高いので一度試すのがおすすめです。

途中、着替えをするところで止まっている人もいるようですが、ドアを開けると先に進めるので是非その先を体験して欲しいです。まさにディズニーの世界が広がっています。

身体の中を探検できるゲームです。自分が小さくなった感覚を味わえます。無料で体験できるのに凄いクオリティです。

ニコニコ動画がVRで楽しめます。ユーザーインターフェースが未来感あるので、ニコニコ動画みたことある方なら一度試してみてもよいと思います。

ハイクオリティの有料ゲームです。VR世界の中でVRゴーグルかけるという不思議な感覚の体験ができます(笑)

以下記事参照下さい。買っても損は無いかな?と個人的には思いました。

私以外の方のおすすめコンテンツ情報です。ここらへんの情報をもとにコンテンツを試しています。

Oculus Goの布教向きな酔わないタイトル|nerd0geek1|note

三半規管の限界に挑戦する、Oculus Goの酔いやすいタイトル|nerd0geek1|note

Oculus Goきた!!!!アプリをいっぱいやる♡♡♡♡♡♡♡ - トマシープが学ぶ

Oculusを便利に使う方法や、楽しみ方を紹介します。随時模索中です。

Oculus Goと動画アプリだと一番相性が良いのが、専用アプリが用意されているNetflixです。ただ、Netflixも最低月額650円で、1年だと7800円とそこそこお高いです。Amazon Prime ビデオ契約している人ならそちらを楽しみたいですよね。Oculus GoだとAmazon Prime Videoは見れない・使い物にならないと思っている人も多いようですが、実はOculus GoでもAmazon Primeビデオを十分快適に楽しむことができます。ただ、少し注意点とある程度事前準備が必要なので紹介いたします。

視聴方法に関しては、Oculus Goのブラウザ機能を使って、Webサイトを見る要領でAmazon Prime Videoのサイトに行くだけです。Amazon Prime Videoのサイトをブックマークしておくとよいでしょう。

注意点としては、視聴ボタンをクリックする前に、以下のように、ブラウザの右上の「デスクトップをリクエスト」というアイコンをクリックして下さい。この操作をしないと動画は見れません。

ただ、このままの状態では、フルスクリーンにできる瞬間が起動時の一瞬だけだったり、早送りも巻き戻しもできないので非常に不便です。そんな不便を解消するために、専用のブックマークレットを作ってくださった神のようなお方がいます。Oculus Goのブラウザで以下のサイトにアクセス下さい。セットアップ方法に関しても、以下のサイトに書いてあります。

http://commitorbit.com/oculusgo/

Oculus Goではコピペも日本語入力もできないので、上記アドレスを暗記して頑張って入力しましょう(この操作が一番大変です)。

上記ブックマークレットを入れると、Oculus GoでAmazon PrimeのビデオのコントロールのUIが使えるようになります。

ここで紹介した内容は、以下サイトのものを参考にさせていただいています(本当に素晴らしい記事です)。この説明だけでよくわからない方は、以下サイトも参照してみて下さい。

Oculus GoでAmazonプライムビデオを寝ながら見る方法 | 生まれ変わったら道になりたい

Oculus Go AmazonプライムビデオでコントロールUIを表示する方法 | 生まれ変わったら道になりたい

Oculus Goで一番もどかしいのは、キーボードが使えない点です。検索するにもURL手打ちするにも大変です(しかも現状日本語も使えません)。好きなURLに簡単に行くには、自分でOculus Go専用のリンク集のページを作って、そのアドレスをブックマークに入れてしまうのが一番簡単かもしれません。最初そのページをブックマークするまでが大変ですが、その後はそのページを更新さえすれば、簡単にリンクで好きなページに飛べます。

自分も実験的に、以下のような専用リンク集作ってみました。上記のAmazon Primeのコントローラのページへのリンクや、この記事で紹介した動画などへのリンクが入っています。もし良ければご自由にお使いください(随時更新予定です)。

http://karalog.hatenablog.com/entry/oculusgo

以下サイトが参考になりました

Oculus GoにUSBケーブルを接続した後、Oculus Goを被ると、デバイスのアクセスの許可の画面が出るので、許可をクリックしましょう。

WindowsだとそのままPC上にマウントされるらしいのですが、Macだとそのままでは見れません。そこで「Android File Transfer」というソフトをインストールします。

コマンドに慣れていてHomebrew使っている人でしたら以下コマンドで一発です。

$ brew cask install android-file-transfer

以下のような画面でファイルがやりとりできます。

スクリーンショットは、Oculus/Screenshots以下にありました。

以下サイトを参考にしました

VRヘッドセット「Oculus Go」に動画を転送する(USBケーブル編) | iPod LOVE

ケース情報です。これは買う予定(買ったら追記します)

#OculusGoの収納に無印のメイクボックス・小がジャストフィットすぎる pic.twitter.com/RimhmH8BmB

— ざっきー (@zakky705) 2018年5月18日

ムフフな動画を見る方は、以下も気をつけましょう。初期設定でも設定するタイミングがあるので、そこで設定した上で確認しておくのがよいでしょう。

Oculus Goのフレンドが

— やさお@めぐるーまー@ARP最高@東雲めぐちゃんの合同同人誌つくってるよ (@Vrnonpro) 2018年5月17日

アクティビティがわかる設定のままでDMMみてるのがわかるとちょっとどきどきしてしまう。。。

周りからアクティビティが設定見えない設定は以下からできます

Oculusアプリを起動

設定>アクティビティの自分のみ

設定動画作った!16秒!#OculusGopic.twitter.com/TLCvMixDMR

現状はOculus Goのアプリではできないみたいです。Facebookと連携すると、Facebookアイコンが自動的に設定されているようですので、不都合な人は注意しましょう。

TIPSではないですが、Facebook登録していない人や、登録したくない人には気になる点ですよね。実は、私もFacebook登録したくない人で、心配していたのですが。特に問題なく使えました。Oculus Roomsも、Oculus IDという専用のIDで検索することができます。

Facebookに登録しないと使えないアプリや機能も多少はありますが、致命的なものはないかなという印象です(少なくとも私が試したかったアプリは全てFacebook登録は不要でした)。

VRアプリ開発もしていきたいなと考えています。ただ、コンテンツ作りこむのは凄い大変そうな予感。とりあえず分かりやすそうな記事をメモしておきます。こちらの方はサンプル作れるようになったら、また別で記事書きます。

Oculus GoでUnity VRサンプルを動かしてみた - 趣味TECHオンライン | 趣味のモノづくりを応援するオンラインメディア

「Oculus Go」に関して簡単にまとめました。この記事では、あえて「Oculus Go」の良さに関しては触れませんでした。こればかりはVRというものの性質上、あんまり説明しても意味がないかなと思っています(むしろ間違って伝わる可能性の方が大きいと感じています)。買って被る、それしかないかな。これが個人で体験できるというのは、かなり衝撃でした。

少しだけ書くなら、自分自身は実はVRに対して今までそこまで良い印象は持っていませんでした(有料の施設でVR体験したとき、ジェットコースター的なものばかりで酷いVR酔いをしたのも大きかったです)。ただ、Oculus Goでその印象は大きく変わりました。VRコンテンツもジェットコースター的なもの以外にも優良なコンテンツありますし、VR会議などの広く使えそうな用途も多くあります。

VRがどこまで普及するか自分自身はちょっと測りかねていたのですが、VRが広く普及する可能性はありえるかもしれないなと思い始めています(そのときは、恐らく今のようなゴーグルの形ではないと思いますが)。そして今のところのキラーコンテンツは、やはり動画でしょうか。Oculus Go + Amazon Primeビデオの組み合わせは、ほんと個人映画館というレベルです。あと、VRのコンテンツの購入は、まさに体験を買うという表現がピッタリくるなと感じます。VRはリアルな体験をデジタル化するデバイスなのだなということをOculus Goで実感しました。

2万円台でこれほど未来感を味わえるデバイスは、なかなか無いと思いますので興味ある方はチェックしてみて下さい。

愛知県の有松に古い町並みがあります。私の周囲の人も、みなこの場所で良い雰囲気の写真を撮るので気になっていました。そんな中、以下のような記事をみてついに我慢ができなくなってその日のうちに写真を撮りに行ってしまいました。

実は私の家から自転車で行ける距離にあるのですよね。もっと早く行けよという話です(笑)

古い町並み撮影してみたのですが…難しいです。全然雰囲気でない!古い町並みじゃないものも結構混じっていると、油断するとすぐ古くもない普通の町並みになってしまう(笑)

ブログ記事みると、必ず紹介されているので、吸い込まれるように入って行きました(笑)

かわいい看板

かわいい看板

少し分かりにくいのですが、この奥の「やまと屋」さんの扉の先の突き当たりにあります

2階がイートインスペースになっています。蔵っぽい雰囲気です

コーヒーとチョコパンいただきました。美味しい!

お店の中の撮影は、一言かけて了承いただいてあります(撮影に関しては、了承欲しい旨の張り紙がお店にありました)。

自転車で行ったので、駅の近くの駐輪場に停めました。料金分かりにくかったのですが、100円/24時間 です。交通系電子マネー(Suica)も使えて、99円になってお得だそうです(笑)

便利ズームの「OLYMPUS M.ZUIKO DIGITAL ED 12-100mm F4.0 IS PRO」で撮影しました。

最近こればっかりです(笑)広角気味で撮りたいのですが、あまり広角にすると古い町並みに関係ないものがすぐ入り込んでしまうので、ズームできるこのレンズが大活躍でした。

RAW現像は、mae (id:hibi-mae) さんの以下記事の「mae0301_3」プリセットを使用しました(現在はプリセット配布停止しております)。

今回、古い町並みにこのフィルムライクなプリセットがバッチリハマりました(と自分は思っています)。多分、このプリセット無かったら今回の記事は公開しなかったと思います。

というわけで今回(いつも?)は、機材とプリセットに助けられた記事でした。有松は近場なので是非また撮影にいきたいなと思っています。

OLYMPUS マイクロフォーサーズレンズ M.ZUIKO DIGITAL ED 12-100mm F4.0 IS PRO

私が影響を受けた、有松の古い町並みの記事の数々です。多分無意識に構図パクってます(笑)

ある日突然妻からおねだりされました

「ねえ、扇風機買っていい?」

「扇風機?うん、これから暑くなるし良いのじゃない?」

高価なクーラーじゃなくて、扇風機をおねだりするなんてなんて経済的なのだろう、さすが私の妻!と思ってすっかり忘れていたある日。その扇風機が届きました。

お値段「39,800円成(購入当時)」

「しゃ、しゃんまんきゅうせんはっぴゃくえんーーーー!」

と叫びながら私が泡吹いてひっくり返ったのは想像にかたくないと思います。

買ってしまったものは仕方がないと、使ってみたのですが、扇風機なかなか良かったです。

3歳になる娘との比較(安全のため電源抜いてあります)

サイズ的には、3歳になる娘とちょうど同じ大きさで手頃(?)ですね。見た目もすごくスタイリッシュです。

羽は特殊な2重構造になっているようです。機能的にもすぐれているようですが、見た目もおしゃれですね。

アップの図

このバルミューダの扇風機、DCモーターを使っているのが特徴となります。DCというのは直流ですね。昔ながらの扇風機は全部AC(交流)モーターを使用しています。DCモーターの特徴は以下となります。

良いところばかりですが、その分扇風機自体のお値段はお高いというわけです。

特に、風量調整が細かくできるためなのか風が非常に心地よいです。これは実際に家電量販店などで並んでいたら是非試してもらいたいなと思います。

また、音もとても静かで一番弱い風にしていると、ほとんどといって良いほど音が聞こえません。その上、心地よい風が得られるので、気分はまるで心地よい風のふく草原にいるかのようです(大げさ)

静音性に関しては、参考までに動画撮って見ました。

前半は、風力を最大にしています。娘の歌に比べて音が非常に静かなのが分かると思います。ちなみに娘はハッピバースデーの歌を歌っていますが、私は誕生日でもなんでもありません。また途中、パワーを最弱にすると娘の歌が終わっても、ほとんど音が聞こえないかと思います。

ただ、このあたりはiPhoneのマイクとの関係もあるので、実際の音もどこかで実際聞いてみるのが良いかなと思います。

実は、最初届いたときリモコンが効かないという初期不良がありました。ちょっと残念でしたが、送り返したら1週間ほどで無料で全品交換になって帰ってきたので、サポートは特に問題ないかなという印象でした。

一部個人情報を消してあります

欠品なども特になかったのですが、よっぽど慌てたのか何故かACアダプタが1個増えていたのが、ちょっとだけ不安でした(笑)

何故か増えたACアダプタ。12Vで使いやすそうだから電子工作にでも使おうかな?

何故か増えたACアダプタ。12Vで使いやすそうだから電子工作にでも使おうかな?

バルミューダのDCモーター高級扇風機を簡単に紹介してみました。お値段はお高めですが、静かで心地よいので、クーラーは苦手でお金出せる人には良いと思います。あとは、大事な人への贈り物とかも喜ばれるかもしれませんね。

以前ディープラーニングを使った物体検出を試してみました。

前回の成果物は以下です。

ただ、このままではちょっと面白いだけで何の役にも立ちません。折角なので何か自前のデータの学習をさせて、世のため人のためになるものを作ってみたいですね(無表情)。

ふと思い出したのは、アダルドビデオのモザイク入れです。あの処理って、実は自動化されていなくて、職人さんが1フレーム毎にモザイクを入れているらしいのです。この作業を自動化すれば、きっともっと世の中に素敵な動画が溢れてみんなが幸せになるはず!

というわけで、モザイクを自動で入れるソフトを作れないか試してみることにしました。名付けて「ディープモザイク」です。途中宇宙語が続くので、結果が気になる方は最後だけ見て下さい。

今回使用するのは、KerasとTensorFlowでSSDを実装している「rykov8/ssd_keras」のリポジトリをフォークして、自分が改造した以下のリポジトリとなります。

最初に、以下の記事を参考にセットアップします。使用するPCはMacかLinuxを想定しています。動作確認した環境は iMac (Retina 4K, 21.5-inch, 2017) + macOS Sierra 10.12.6 です。LinuxはUbuntu 16.04で確認をしています。

主要なライブラリのバージョンは以下です。

anaconda3==4.4.0 tensorflow==1.0.0 keras==1.2.2 opencv-python==3.3.0

具体的な手順としては、上記記事を参考にpyenvをインストールしたあと、以下コマンドでAnaconda3と主要なライブラリをバージョン指定してインストールして下さい(最新バージョンだと動きません)。

$ pyenv install anaconda3-4.4.0 $ pyenv global anaconda3-4.4.0 $ conda create -n ssd anaconda $ pyenv global anaconda3-4.4.0/envs/ssd $ pip install numpy==1.13 $ pip install tensorflow==1.0.0 $ pip install keras==1.2.2 $ pip install opencv-python==3.3.0.10

教師データを収集します。今回は卑猥なロンスタさんの動画を使用しました。フリー素材のロンスタ(id:lonestartx) さん、いつもありがとうございます!下記リポジトリのfree_dataというディレクトリにも実際に使用したデータが、アノテーションデータ付きでアップロードされています。

もし画像を使って同じことをやりたいという人は、ネットからスクレイピングするのが良いと思います。以下にスクレイピングする方法の記事紹介しますが、この方法で集められる画像は量が少ないのでさらに一工夫必要かもしれません。

また、画像の場合はここで後の処理のために全ての画像ファイルの拡張子をJPEG形式(.jpg)にしておいて下さい。これは、アノテーションに使用する「VoTT」というソフトがエクスポートするxmlファイルのfilenameに何故かファイルの拡張子が入れてくれないため必要な処理です。

アノテーションツールとしてVoTTというマイクロソフト謹製のソフトを使います(Twitterで教えてもらいました)。他にも、labelImg、ImageNet_Utils、labeling_for_object_detection等のツールを比較したのですが、以下の4点でVoTTを選びました。

実は前述したように「エクスポートするxmlファイルのタグにファイルの拡張子を入れてくれない」とか「ファイルパスの指定が絶対パス」などの細かい不満点に後で気付いたのですが、運用でカバーできるのでそこは割り切りました。

VoTTは以下からダウンロードできます。

私はMac用のバイナリファイル「VoTT-OSX.zip」をダウンロードしました。

起動すると、以下のような画面が表示されます。今回は動画を使うので、右の「Video」をクリックします。

動画を選ぶダイアログが表示されるので、動画を選択します。なお「VoTT」で読み込める動画の形式は限られているようなので、もし動画が読み込めない場合はあらかじめ動画を変換しておきましょう。私の場合mov形式のファイルが読み込めなかったので、あらかじめiMovieでmp4形式に変換しておきました。

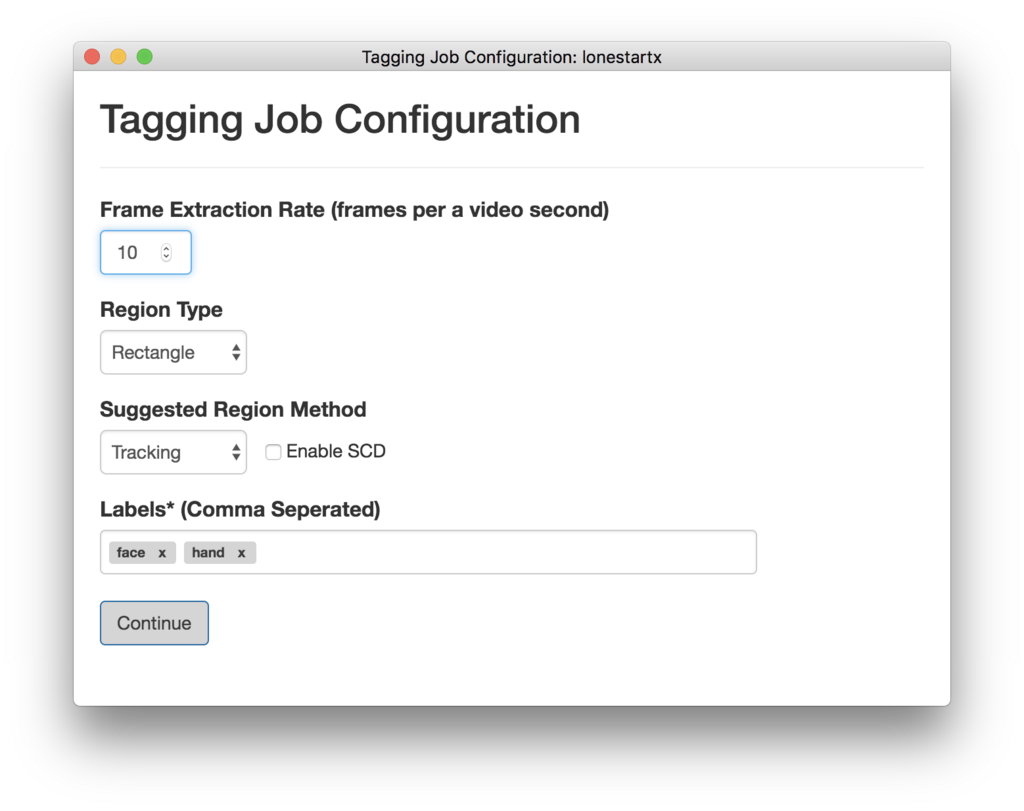

動画を読み込むと以下のような画面が表示されるので、Region TypeにRectangleを選び、検出したいカテゴリのラベルを「Labels」に加えます。今回は、卑猥なロンスタさんの顔「face」と手「hand」とします。

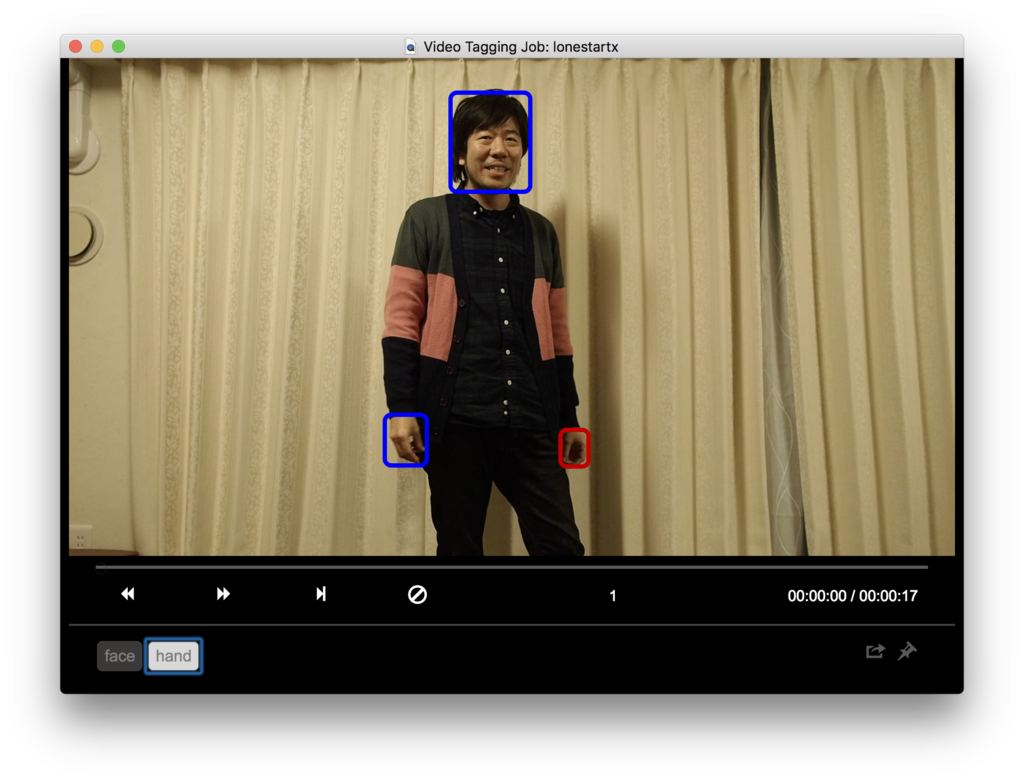

ここからが地獄のアノテーション作業です。以下のように検出したい物体を四角(Bounding Box)で囲って、タグを付けていきましょう。

ブレた画像等、なるべく多くのパターンでアノテーションしておきます。ここでの作業が精度の肝となります。そこの人「全然自動じゃ無い!」とか言わないように!

ちなみに「VoTT」は、動画を読み込んだ場合、タグをつけてから次のフレームに移動すると、自動で判定してタグをつけてくれます。めちゃめちゃ凄いです。もちろん失敗する場合もあるので、そのときは手動でタグ付けして下さい。

疲れたので、100フレーム分くらいタグをつけたら良しとします。理想的には、数千から数万くらいのデータはあった方が良いようですが、今回はこの程度で勘弁してあげましょう。

画像の場合も、基本的には同じ要領でアノテーションが可能です。

タグ付け終わったら、一旦ここで File -> Saveで保存しておきましょう。教師データのフォルダと同じ場所にjsonファイルが生成されます。このjsonファイルがタグ付け情報なので、教師データと一緒に大切に保存しておきましょう。jsonファイルは、テキストファイルなので一度どんなものか中身を見ておくのも良いと思います。以下のようなjsonファイル用ビュワーを使うのもオススメです。

Python製のマルチプラットフォームJSONファイルビューワーPyJSONViewerを作った - MyEnigma

以下コマンドでリポジトリをクローンします。

$ git clone https://github.com/karaage0703/ssd_keras

VoTTを起動して、SSDの形式でExportします。具体的には、メニューのObject Detection->Export Tagを選択します。

すると以下の画面が表示されるので、以下のようにExport Format:はTensorflow Pascal VOCとして、Output Pathにssd_keras/PASCAL_VOC/dataを指定します。

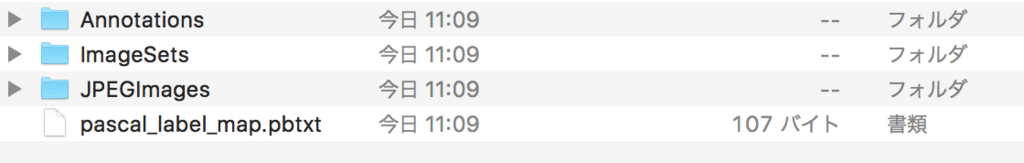

ssd_keras/PASCAL_VOC/dataに以下のようなファイルが生成されたらOKです。

次に、以下コマンドを実行してXMLファイルからpickle(.pkl)ファイルを生成します。

$ cd ssd_keras/PASCAL__VOC

$ python get_data_from_XML.py

今回は、「face」「hand」の2つのタグという前提ですが、もし異なる数のタグを学習させたい場合は、ssd_keras/PASCAL_VOC/get_data_from_XML.pyをあらかじめ修正しておいて下さい。具体的には、 self.num_classesにラベルの数を入れて、def _to_one_hot関数の中身を、ラベルの名前に合わせて修正して下さい。

def__init__(self, data_path): self.path_prefix = data_path self.num_classes = 2 self.data = dict() self._preprocess_XML() ... def_to_one_hot(self,name): one_hot_vector = [0] * self.num_classes if name == 'face': one_hot_vector[0] = 1elif name == 'hand': one_hot_vector[1] = 1 ... import pickle data = XML_preprocessor('data/Annotations/').data pickle.dump(data,open('supervised_data.pkl','wb'))

pickleファイルが生成できたら、以下実行してpickleファイルをきちんと読み込めるか確認して下さい。以下のように検出したいラベルの座標が表示されればOKです。

$ python >>> import pickle >>> f = open('supervised_data.pkl', 'rb') >>> data = pickle.load(f) >>> print(data.keys()) dict_keys(['lonestartx_free_frame_1', 'lonestartx_free_frame_10', 'lonestartx_free_frame_11', 'lonestartx_free_frame_12', .... >>> print(data['lonestartx_free_frame_1']) [[ 0.433333330.068518520.5156250.277777781.0. ] [ 0.358333330.722222220.4093750.840740740.1. ] [ 0.5656250.70.622916670.79629630.1. ]]

続いて、以下サイトから重みパラメータ weights_SSD300.hdf5を入手します。。ブラウザはGoogle Chrome推奨です。

ダウンロードしたweights_SSD300.hdf5は、ssd_kerasディレクトリ直下に置きます。

いよいよ学習ですが、その前にssd_kerasディレクトリ直下のSSD_train_custom.pyを修正して下さい。

修正する必要があるのは25行目のクラス数のNUM_CLASSESです。分類したいクラスの数(ラベルの数)+ 1を設定します。1を加えているのは、どれにも当てはまらないクラスがあるためです。今回は、2つのラベルなので3を入れています。

修正したらssd_kerasで以下のコマンドを実行して下さい。

$ python SSD_train_custom.py

学習が終わると、以下のようにテスト結果が表示されます。これらの結果は、元々のソフトでは表示されなかったので私が追加したものです。

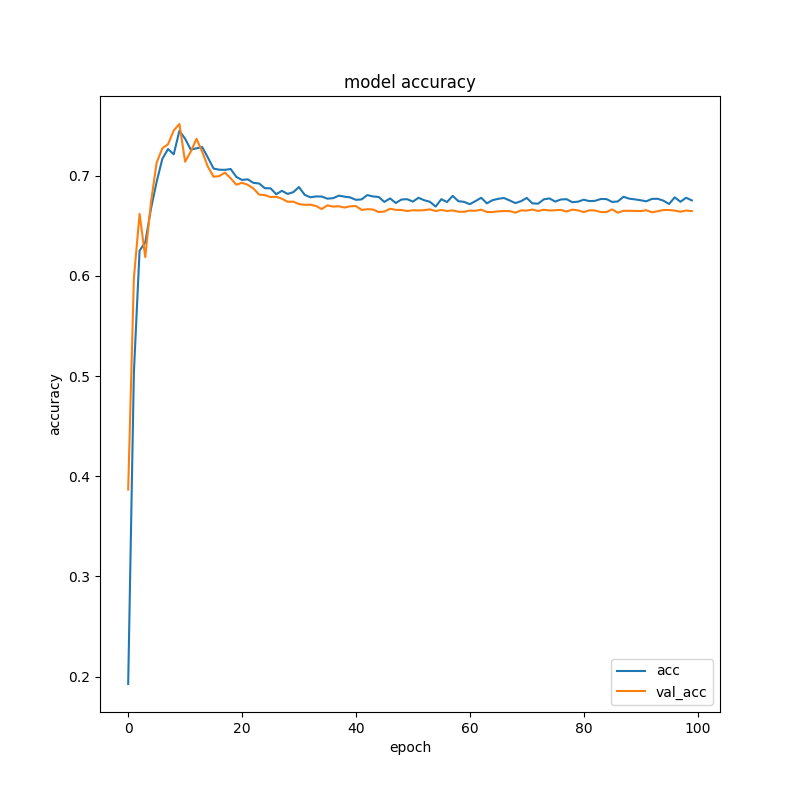

以下はacc(精度)の結果です。詳細の説明は省きますが、val_accというのが本当(?)の精度です。0.6〜0.7あたりで収束していますね。教師データの数が少ないのでこんなものなのかもしれません。

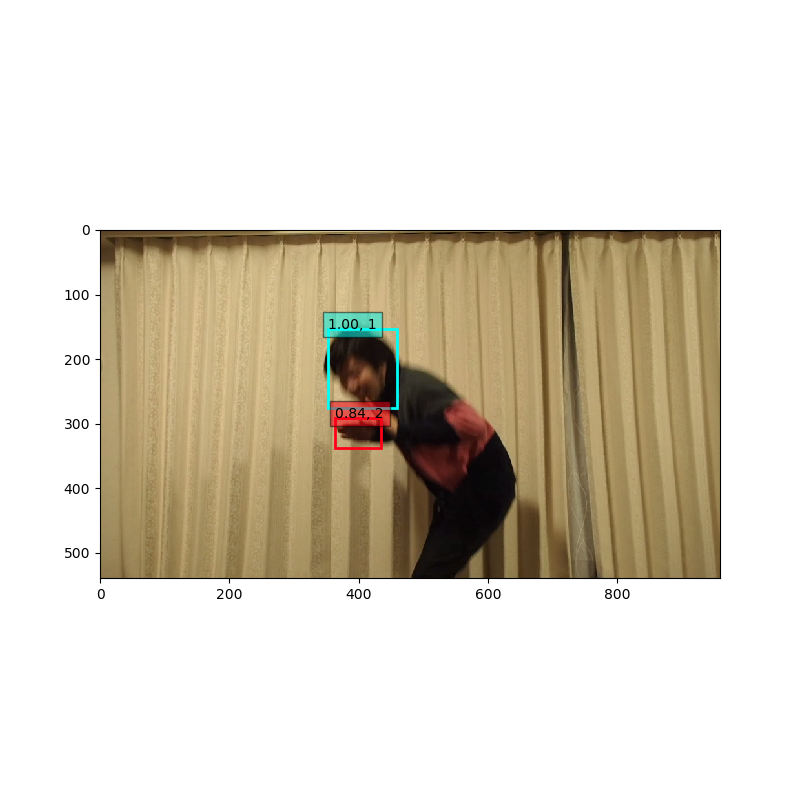

最後にランダムに選択したテストデータで結果が表示されます。

良さそうな感じですね。

いよいよ学習したモデルを用いてモザイク動画を生成します。

SSD_pred_video.pyというファイルの以下部分を、自分の使用したラベル、学習したデータ、使用する動画ファイルのパスに修正します。学習データは、checkpointsというディレクトリにweights.xx-x.xx.hdf5というファイルがたくさんあるので、そのファイル名を指定して下さい。基本には世代が進んだ学習モデルを用いた方がよいので 100世代目のweights.99-x.xx.hdf5というファイルを用いるのが

よいでしょう(後ろの x.xx の部分は学習を実行するたびに変わります)。

voc_classes = ['face', 'hand']

model.load_weights('./checkpoints/weights.99-2.78.hdf5', by_name=True)

vid = cv2.VideoCapture('./free_data/lonestartx_free.mp4')修正したら、以下実行しましょう。

$ python ./SSD_pred_video.py

./free_data/output.aviというモザイク処理された動画が生成されます。

ディープラーニングでのモザイク処理は以下のようになりました。

結構ちゃんとモザイクかけれていますね!たまにモザイク外れているけど、気にしないことにしましょう(笑)

ディープラーニング使って、卑猥な動画(?)に自動でモザイクをかけるソフト「ディープモザイク」を作ってみました。今回は動画を大量にアノテーションしているので、全然自動化という感じがしないかもしれませんが、大量の教師データさえ蓄えれば、実際の商業用のムフフな動画でも、かなり高精度にモザイクをかけられるのじゃないかなと思っています。

本当に使おうとすると、今回の様な四角(Bounding Box)ではなく、ピクセル単位で範囲を指定できる、セマンティックセグメンテーションを用いた高精度な物体検出が必要になってくるので、もっと難易度は上がるのかなと思います。

ただ、自前の動画データとディープラーニングという組み合わせに関しては可能性を感じていただけたのでは無いかと思います。この記事で興味持った方は、是非色々な応用例を試していただけたらと思います。私も世のため人のためエロのため(?)ディープラーニングの活用例を色々考えてみたいと思います!

本記事で使用したプログラム、Kerasというディープラーニングのフレームワークを使用したのですが、プログラムの動作の理解、改造にあたっては、Aidemyさんの「ディープラーニング基礎」が非常に参考になりました。

ディープラーニングを簡単に利用できるソフトは色々出て来ていますが、やはり自前データを使って新しいことをやろうとすると、ディープラーニング自体の基礎や、Pythonの知識、TensorFlow + Kerasというディープラーニングのフレームワークの使いこなし等様々な知識が必要になることを改めて実感しました。今回も「Aidemy」さんのコースにない物体検出にチャレンジしてみたのですが、基礎の重要性を感じるとともに、学んだことは応用きくことが分かりました。もしディープラーニングで何か新しいことをやりたい人はAidemyさんがオススメです!そして、Aidemyさんには是非、物体検出のコースも作って欲しいなと思います(笑)

本記事は、以下のAidemyさんのコンテストに参加しています。

今回の物体検出の例は、環境設定が必要ですし、教師データのアノテーションも大変で、実践するにはハードル高い内容となります。そこで、もっと手軽に機械学習・ディープラーニングを学習したいという人のために「Google Colaboratory」を使って環境設定不要でブラウザだけで画像認識を学べるチュートリアルを有料noteで公開しました。

非常に実践的な内容となっていますので、Aidemyさんのプログラムと合わせて手を動かしながら実践いただくと理解が深まるのではないのかなと思っています。興味のある方は、こちらも合わせてご参照下さい。

最近会社の行き帰りに「Voicy」を聞いています。「Voicy」は、ブログの音声バージョン的なサービスです。個人ラジオ局と言い換えても良いかもしれません。Podcast知っているなら、Podcastと基本は同じと思ってもらえば良いと思います。

PCでも聞けますし、スマホならアプリがあるのでアプリで聴くのが良いでしょう。

「Voicy」の特徴としては、どのチャンネルも10分〜20分程度と短めで、通学・通勤に聞くのに丁度良いボリューム感ということと、参加に審査があるため、コンテンツのクオリティがある程度担保されている(極端にダメなものは無い)ところでしょうか。ランキング上位の人は、ネットの有名人の方が多いようです。ただ、私が良く見る層とは異なるようで「名前は聞いたことあるかも」くらいの方が多かったです。自分とは全然違う考え方の人が多くて、なかなか面白かったです。そんな中でも、面白いなと思ったVoicyのチャンネルを紹介したいなと思います。

ランキング1位だったので聞いてみました。内容としては、「いかにこの資本主義で働かずに生きて行くか」ということを考え、実践しているサウザーさんの自分語り的なコンテンツです。

確かにこういう話に興味を持つ人って今の時代には多いのかもしれませんね。私自身は、あんまり真似したいなというという気持ちは起こらなかったのですが(働きたくないというのは凄い分かりますが)、自分とは違うバックグラウンドとか考え方の人の話を聞くというのも「こういう人もいるんだ」という点で視野が広がって良いかなと思いました。

あと、特筆すべきはその話術ですね。例えば、自分の話に説得力を持たせるために、日本の武将の逸話、三国志のエピソードなどをさりげなく引用したり。ここぞというところで、具体的な自分の体験談を交えてくるのですよね。かなり多くの書籍を、自分の仮説を持って読み込んでいることが伺えるので、その考え方も含めて相当頭がキレる人だなと思いました。やはりランキング1位になる方は只者ではないですね。

ちょっとこの考え方は取り入れてみたいなと思いました。というわけで、よく引用されている「孫子の兵法」を読んでみたりしています。ちなみに、ずっと「兵法」って孫子さんという人が書いた本だとばかり思っていたのですが「孫子」というのが兵法書のことで、書いた人は「孫武」さんらしいです。自分全然教養ないですね…

Microsoftのエバンジェリスト澤円さんのチャンネルです。以下の記事を読んでから気になって聴き始めました。

しゃべりは朴訥な感じで、めちゃめちゃうまいというわけでは無いのですが。上記の記事もそうですが、内容が素晴らしいものが多いなと思いました。具体的な題名はあげませんが、仕事で悩んでいる帰り道に、とあるエピソードを聴いてもの凄い勇気付けられて元気が出ました。言葉の力というものを、久しぶりに信じたくなった瞬間でした。

全体的に前向きで元気がもらえる内容が多く、仕事で悩んでいるビジネスマンにおすすめです。

最後に「Voicy」以外の音声ブログも紹介したいと思います。

AruFaさんと、ダ・ヴィンチ・恐山さんという最狂コンビのラジオです。頭空っぽにして聞くととにかく楽しめます。Youtubeにもあるのですが、ラジオがわりに聞く場合は上記サイトから音声ダウンロードのページに飛んで再生するのが良いです。以下のオススメを順に聴いています。1本1本が短めなのも良いです。

うちだま (id:uchidamax)さんと清水亮さんのPodcast。人工知能(ディープラーニング)関係の内容の濃いPodcastです。

ディープラーニングに興味のある方は必聴です。この番組は1本1時間近くあるので、長距離移動のときに一気に聴くのがオススメです。更新はまちまちです。

あと、Podcastだと昔放送していた高橋名人の「16SHOT RADIO」という番組が好きでした。放送聴けなくなっちゃったのが残念だったのですが、検索したらニコニコ動画にありました。権利怪しそうなので、リンクは控えます(笑)。ファミコン世代の人にはオススメです。

音声ブログの「Voicy」のおすすめチャンネル+αを紹介しました。たまに、違ったプラットフォーム上のコンテンツをのぞくと、全然違ったカルチャーとか、考え方の人がいたりするから面白いなと思います。「Voicy」も自分の考え方とは相入れない人が多いのですが、定期的に自分にとって異質なものを取り入れるってのは大事かもなとか思っています。

「Voicy」や「Podcast」などの音声ブログ、音声だけで手軽に楽しめるので通学・通勤のお供にいかがでしょうか?という話でした。

Oculus Go買って色々遊んでいます。

一通りコンテンツを遊んだら、やっぱりチャレンジしたいのがオリジナルのVRコンテンツ作成ですね。以下あたりを参考にすればサンプルくらい簡単に動かせるだろと思っていたのですが、私がUnityもAndroidもVRも全てが初心者だったので、かなりハマってしまいました。

Oculus GoでUnity VRサンプルを動かしてみた - 趣味TECHオンライン | 趣味のモノづくりを応援するオンラインメディア

自分のメモとして参考までに手順を残しておこうと思います。私のようなVR初心者には参考になるのじゃないかなと思います。

具体的には、以下の5つの手順を踏みました。10GBくらいの空き容量とそこそこ時間が必要です。

順に実施していきましょう。

実は「Oculus Go」はAndroidで動いているので、AndroidのSDKが必要です。以下からAndroid Studioなるものをダウンロードして、インストールします。

ただ、注意点として最新のSDKだとうまくいかないらしいので、一部ファイルを差し替える必要があります。

具体的には、以下サイトからtools_r25.2.5-macosx.zipというファイルをダウンロードして解凍します。

するとtoolsというフォルダが出来るので、/Users/username/Library/Android/sdk/toolsというフォルダに上書きコピーしましょう(usernameのところは、ご自身のユーザー名になります)

JavaのSDKも必要になるようなので、以下サイトで「jdk-8u171-macosx-x64.dmg」というファイルをダウンロードしてインストールします。

Java SE Development Kit 8 - Downloads

VRアプリを開発するメインソフトとなるUnityをインストールします。以下公式サイトからダウンロードできます。

Homebrew Caskを使用する人なら、以下コマンドでもOKです。

$ brew cask install unity

Homebrew Caskに関して詳細は以下記事参照ください。

また、Unityが初めての方は、以下でUnity IDを登録しておきましょう。

Unityを起動して、新しいプロジェクトを作成しましょう

メニューから「File -> Build Setting」を選択すると下のような画面になるので、以下のようにAndroidを選択して、右側真ん中あたりの「Open Download Page」 をクリックします。

すると、「UnitySetup-Android-Support-for-Editor-2018.1.0f2.pkg」というファイルがダウンロードされます。ファイルはインストーラーなので、起動してインストールしましょう。

インストール完了したらUnityを再起動します。同じようにメニューからBuild Settingを開いて、Android左下のSwitch Platformをクリックしましょう。

続いて、メニューの「Unity -> Preference」からSDKとJDKのフォルダを入力します。

SDKの場所は以下です(usernameにはご自身のユーザー名となります)。

/Users/username/Library/Android/sdk

JDKの場所は以下です

/Library/Java/JavaVirtualMachines/jdk1.8.0_161.jdk/Contents/Home

続いて、Player Settingを行います。ここは分かりづらいのですが、Build Settingの画面の左下の「Player Setting」をクリックすると、以下の画面のようにUnityのメイン画面の右側に「Player Setting」というウィンドウが現れるので、ここを設定します。

その後、「Company Name」と「Product Name」を設定します。ここは適当で良いのですが、注意点として、下の方にある「Identification」の「Package Name」というところで、 com.Company Name.Product Nameという設定をしないとビルドするときエラーになってしまいます。

例えば、「Company Name」をkaraage、「Product Name」をtestとした場合は、以下のようにPackage Nameをcom.karaage.testとしなければなりません。

また、その下のMinumum API LevelはAPI level 16を選ばないとエラーが発生しました。

その後、さらに下の「XR Setting」を設定します。

以下の図のように「Virtual Reality Supported」にチェックを入れて、Virtual Reality SDKsにOculusを選択します。

これでようやくUnityの設定は完了です。いよいよOculus GoとPCをUSBケーブルで接続します。

Oculusが起動すると、USBでマウントしてよいか的な画面がOculus Go上に表示されるので、あらかじめ許可しておきましょう。

そのあとUnityの「Build Setting」の画面から「Build & Run」をクリックしましょう。

以下のように、Oculus Go上でデフォルトの3D画面が表示されればOKです。

ここまで環境設定できたら、VRサンプルに関しては以下のサイトを参考にほぼ詰まらずできました(感謝)。

Asset StoreでVR Samplesを検索して、ダウンロード(なんと無料です)します。

インポートしたら、Assets/VRSampleScenes/Scenes/MainMenuをHierarchy(Unityの左側のメニュー)にドラッグしましょう。

以下のような画面が表示されたらOKです。

Unityの「Build Setting」の画面から「Build & Run」をクリックしましょう。

Oculus Go上で以下のようにVRサンプルアプリが起動します。

以下のようなサンプルゲームが遊べます。普通に楽しく遊べるクオリティです!

「Oculus Go」でVRアプリ開発環境構築してみました。初心者すぎて大変でしたが、なんとかこれでVRアプリを作れそうです。ただ、Unityが全然分かっていないので、色々勉強しないと…です。何かUnityの本でも買ってみようかなと思っています。

Oculus Go特有の情報に関しては、Web情報を漁った方が良さそうですね。以下あたりが参考になるのかなと思っています。

本記事は公開から3ヶ月(9月中頃)までトップに表示予定です。

最近、詳細はここには書けませんが諸々の事情で仕事で悩んでいます。

最初に誤解されないように書いておくと、会社だけが悪いとか自分だけに問題があるとは思っていません。私の会社もそこそこ大きな会社なので(念のためですが、自慢しているわけではないです。私個人とは何の関係もないので)、方針や組織が変わるのも仕方ないと思っていますし、そこでミスマッチが出てくるのは仕方がないのかなと思っています。

ただ、ここ2,3年の仕事の環境が良かった分、情けない話ですが自分の力が全然発揮できなかったり、必要とされてないと感じたり、何の価値があるのか(自分には)全く理解できない資料を長時間作り続けるのが、想像以上につらく将来を考えても不安になってしまいました。

そんな中以下のこと呟いたら

組織が変わってから、仕事が全然出来てなくて、色々考えてばかりいる。風向きが変わるの待ってたら自分がどうかなっちゃいそうだなこれ…

— からあげ (@karaage0703) 2018年6月5日

noteの代表とCXOからのまさかのコメント!

noteのユーザーと記事分類器作ってほしい

— 深津 貴之 / THE GUILD (@fladdict) 2018年6月5日

これマジでお願いしたいです。

— 加藤 貞顕 (@sadaaki) 2018年6月5日

誰かに必要にされるのって、もの凄い嬉しいし、自分を必要としてくれる人のために何かしたいし、そう人たちと繋がりたいなと改めて思いました。はてなブログに書くのも何ですが、noteは素晴らしいサービスなので、何らかの形で貢献していきたいと改めて思いました!リクエストに関しては、まずは今できる範囲で何か考えてみたいなと思います!

このときは、その日のうちに辞表叩きつけてnoteにジョインしに行こうとも思ったのですが、一旦冷静になりました(笑)

そして、家族にも正直に悩みを打ち明けて色々話して、改めて家族の大切さを実感しました。今のところのまとめとしては以下です。

昨日は少し思いつめてしまったけど、色々な意見を知って落ち着いてきた。焦らずじっくり考えることにした。以下3つを心がけよう

— からあげ (@karaage0703) 2018年6月6日

- 仕事は自分の身体を第一にしつつ、自分を応援してくれる人のために誠実に頑張る

- 家族の笑顔を守ることを大切にする

- 平常心を保つために選択肢を持つ

頑張ろっと!

結論としては、色々行動を起こすことにしました。そのうちの1つとして、環境を変えることを前向きに考えようと思っています。

具体的には、以下の本に書いてあった「毎年転職活動」というものをしようかと思います。この本の作者の尾原さんは、12回の転職を重ねている方です。ここでは詳細紹介しませんが非常に興味深く、今の自分に刺さる内容でした。今回の行動のきっかけの1つにもなっています。

どこでも誰とでも働ける――12の会社で学んだ“これから"の仕事と転職のルール

転職活動に関しては、転職サイトに登録するはもうしているので、今回は加えてブログで公開転職活動をしてみようと考えました。

最近は、ひよこ大佐さんという方が見事にTwitterで転職活動を決めたと話題になっていたので、はてなブログで転職活動するのも、悪くはないのじゃないかなと勝手に思っています。

昔、ブログ経由でエンジニアとしての仕事の依頼を受けたことも何度かあるので(本業があるので受けれませんでしたが)、ジョブオファーに関しても可能性はあるのかなと淡い期待を抱いています。

転職活動として、まずは職務経歴書を公開することにします。書いたことないので、以下サイトを参考にしました。

特に決まったフォーマットは無いらしいので、自分なりに重要と思うポイントを書いていきます。

愛知県の組み込み系のエンジニアとして、清く正しく元気よく働いてきました!

実績は、詳しくはここでは書けないのでスキルをみて察してください。自分が関わって世に出た製品は3製品程度です。テレビCMで、1度自分の作った基板が入っている製品を見たことがあるとか、そういうレベルです。

以下3点を重視しています。

自分が得意なのは、自分で手を動かしてモノづくりをすることです(というかそれしかまともにできません)。作る対象は、大きな拘りはありません(ハードでもソフトでもそれ以外のコンテンツでもよいです)。自分のスキルに関しては、以下項目を参照下さい。飛び抜けて何かが得意というわけではないので、複数の領域のスキルを組み合わせて自分の価値を生かせればと思っています。

働きたい組織として、今一番共感しているのは、IAMASの小林先生の「イノベーションマネジメント」です。

このような新しいことを生み出していける風土の組織で働きたいです。理想は高く。

プロとしての経験は、ハードウェア設計(回路・基板)です。他は、ほとんど仕事でなく自主学習で身につけた内容です。そちらに関してはブログにアウトプットしていますので、その内容でレベル感を判断いただければと思います。

電源回路・Intel系CPU周辺回路等経験有りです。回路CADも使えます。EMC設計や対策もできます。

10層ビルドアップ基板までは経験ありです。部品数は数百から1000点くらいあった記憶があります。なんだかんだで20は超える数の基板つくってきました(そして沢山失敗しました)。

基板設計に関しては、構想と指示のみでアートワーク自体はアウトソーシングです。

海外出張に1人で2週間いって、現地のエンジニアとうまくコミュニケーションとって製品の立ち上げをした経験あります。一時期は、毎週海外メーカと電話会議していました。TOEICは700点で打ち止めです。

英語の仕様書や論文なども、必要に応じて読んでいます。積極的に海外で仕事がしたいという希望は特にありませんが、必要ならなんとか…というレベルです。

製品開発のリーダーをしていたこともあります。詳細はここでは割愛します。

Raspberry Piちょっとできます。今までやってきたことは以下記事参照下さい。

IoTの真似事的なことはしたことあります。

趣味レベルですが、イベントで数回撮影のお仕事を手伝っています。

撮影した写真などは以下参照下さい。

まともに書けるのはPythonくらいです。C++は多少ならというレベルです。Git、Linuxのコマンドは一通り使えます。

ソフトはプロとしての経験もありませんし、正直プログラミング単体ではトップレベルには遠く及ばないと自覚しています。他のスキルとも掛け合わせてのメリットをとらえていただければと思っています。

GitHubで個人で作ったソフトなど公開していますので、レベル感は以下で確認下さい。

ROSがちょっとできます。以下記事でルンバ改造したりしています。こちらは、もっと凄いこともできます。

自己学習のレベルですが、流行りの人工知能ちょっとできます。研究者でないので、最先端の研究はできませんが、OSSを活用したエンジニアリングは可能と思っています。

1冊、協力者として「自分で動かす人工知能」という書籍に名前もクレジットされています(以下参照下さい)

今までネットで公開してきた内容は、以下記事の一番最後の項を参照下さい。

画像処理に関しても、2次元・3次元ともに基礎的なこと(フィルタリング等)はできます。

20年近く、ネットに文章をつづっています。

はてなブログランキングでは、2回トップに輝いたことがあります。

また、「はてなニュース」様、「変デジ研究所」様などの著名なサイトに複数回の寄稿を実施しています。

仕事の内容によっては、ある程度広報的な活動もできるかもしれません。

Maker Faireに趣味の電子工作で出展しています。

機械学習(ディープラーニング)・ロボット・VRです。

VRはまだスキルはないですが、Oculus Go購入して開発環境セットアップまでは実施しました。UnityやC#の勉強を開始し始めたところです。

会社の規定が2ヶ月前に退職の意思を伝えることですので、決まってから最短で2ヶ月後となります。2.5ヶ月から3ヶ月程度を見ておく必要があるかと思っています。

転職活動期間としては、3ヶ月から最大で半年をイメージしています。

愛知県でマンション買ってしまったのと家族もいるので、できれば愛知で働きたいです。

ただ、遠隔地でも2週間がっつり働いて、2週間リモートワークというような働き方もできないかなと考えています。

残業は無しが希望です。土日休み希望です。

30代半ばです。そんな若くないです

正社員希望です。可能なら長く働きたいです

PC環境などは、自分の能力が発揮できる環境をそろえたいです。大きい机、ディスプレイ、PCはMacが選択できると理想です。

IT人材は需要が急増しており、求人検索エンジンの調査ではAI/人工知能/機械学習の求人は最高年収が4,600万円、データサイエンティストは3900万円です。

— マスクド・アナライズ (@maskedanl) May 31, 2018

その他職種も、最高年収2-3000万円はザラです。

なお、「採用決定時にはショボい金額を提示する」というライフハックも聞いた事があります。 pic.twitter.com/8fY6dRAnTA

上記内容によると

なので、全部ができると1億くらいの価値があると言っても良さそうです。今なら、期間限定93%割引で700万円以上でいかがでしょうか?

公開転職活動を開始しました。条件は当たり前ですが、自分の都合の良いことばかり書いています。完全に満足できると考えているわけではありませんので、お気軽にお声かけて下さい。

もちろん私自身も、ただ待っているだけのつもりはないです。ここで職務経歴書を書いたのは、改めて自分のスキルの棚卸しや、やりたいこと、働くための制約・条件を自分自身整理したかったためで、自分からも気になった会社・組織にはなんらかの形でアクションを取っていきたいと考えています。その中で魅力的な会社・組織を色々知れたら良いなと思いますし、そういうところに関してはたとえ転職することが無くても、何らかの形で関わったり、お手伝いできる関係が生まれたら良いなとも考えています。

また、今回Twitterで仕事のことつぶやいて非常に大きな反応をいただき、多くの人が仕事やキャリアで悩んでいるのだなと改めて感じました。正直、自分も悩んでいますし不安もあります。でも、これからどんどん若い人の人口が減って行く中、多くの人が自身の力を最大限発揮して、会社のためだけでなく、本当に必要としてくれている人に対して価値を提供して行けるようになることが大事なのじゃないかなと考えています。

このような活動に対して「ちょっと仕事が辛いくらいで甘い」とか「軽々しく転職なんて考えるべきじゃない」とお思いになる方もいらっしゃるかもしれませんが、自分なりに真剣に考えた決断とアクションです。人の苦しさって、その人固有の絶対的なものなので、残業時間がxx時間とかそういう指標で測るものでもないなと思っています。実際、昔に残業を月に100時間以上やっていたことありますが、気持ち的には今の方が辛いです(まぁ、100時間も辛かったですしもうやりたくないですが…)。

もちろん、1つの会社で長く働くことも素晴らしいことだと思いますし、その方向でもアクションを起こしています。ただ、自身の力でどうにもならなかったとき、そのまま身体や心を壊してしまうわけにはいかない(そういう人たちを会社でたくさん見てきました)ので、自分と家族のためにも今回の行動をとっています。ネットには、絶望するときも希望をもらうときもありますが、今回は自分が信じるネットの可能性に賭けてみたいと思います。

正直どうなるかわかりませんが、何かしら良い方向に向かえば良いなと思っています。応援いただけると非常にうれしく思いますし、色々な人の仕事の話が聞きたいなと考えていますので、是非悩んでいる方は色々お話させて下さい。直接でもOculus RoomsでもOKです。つい先日もスケベサイエンティストのDAIさんとキャリアに関して熱く語り合いました(笑)

スケベサイエンティスト DAIさん(@never_be_a_pm )とOculus Roomsでオセロしながらお話している様子 pic.twitter.com/euFAzHVYfJ

— からあげ (@karaage0703) 2018年6月9日

最後になりましたが、本件の私への問い合わせはTwitterのDMか、メールフォームからお願いいたします(Twitterの方を推奨いたします)。

前行ったゲーム合宿でのNintendo Switchゲーム体験が忘れられず、ついにNintendo Switch買ってしまいました!(といってもこの記事が公開される2週間以上前の話ですが)

Nintendo Switch 本体 (ニンテンドースイッチ) 【Joy-Con (L) ネオンブルー/(R) ネオンレッド】

ジャーン

ジャーン

ゲームはマリオ オデッセイを買いました。ゼルダ欲しかったけど、無限に時間が溶けそうなので…

とりあえず本体だけ買っていたのですが、今は新しいゲームも簡単にゲーム本体からクレジットカードで課金してソフトがダウンロードできるのですね。こりゃヤバい…

2人プレイができるので、最近は夜な夜な夫婦で少しずつプレイして進めています。ライトな協力プレイが良い感じですね。

Nintendo Switch買ったというそれだけの記事でした(笑)据え置きでゲーム機買うのも、自分で買ったゲーム機でゲームプレイするのもほんと久しぶりです。もともと私がプログラムに興味を持ったのが、自分でゲームを作りたいというところだったので、なんかその原点を思い出しているような気持ちになります。

Oculus Goも買ったし、Nitendo Switchで最新の研究して何かVRのゲームにチャレンジしてみたいなーとか夢想しています。Unityとか出来るかな。

あとは、Nintendo Laboも子供と一緒に遊んで、魔改造してやりたいなと思っています!まずはマリオクリアしなきゃ!

Nintendo Labo (ニンテンドー ラボ) Toy-Con 01: Variety Kit - Switch